VLM-R1:具有更高稳定和泛化能力的R1风格视觉语言模型

VLM-R1是什么?

VLM-R1(Visual Language Model - R1)是由Om ai Lab团队开发的一个全新的开源视觉语言模型。它的核心在于将DeepSeek R1方法成功迁移到视觉语言领域,实现了更高的稳定性和泛化能力。

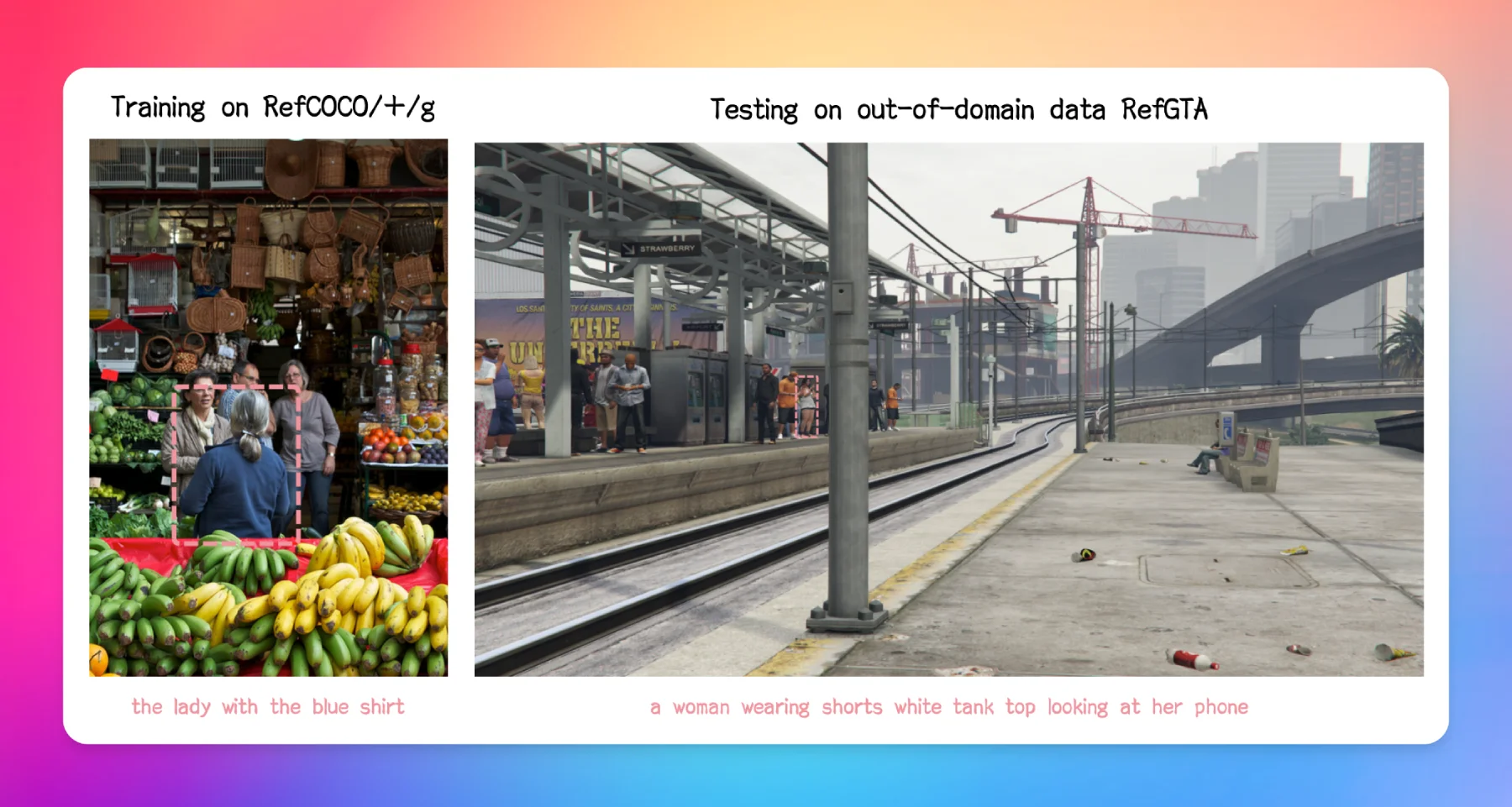

VLM-R1基于Qwen2.5-VL构建,并通过强化学习提升了视觉理解能力。在视觉任务中,尤其是在跨域数据理解方面,其表现优于传统的SFT模型,显示了强大的视觉内容理解能力,是多模态AI发展的重要突破之一。

VLM-R1的技术背景:

VLM-R1的灵感来源于DeepSeek团队去年开源的R1方法,该方法采用GRPO(Group Relative Policy Optimization)强化学习技术,在纯文本大模型上取得了显著的效果。VLM-R1团队将这一方法应用于视觉语言模型,成功打开了多模态领域的新局面。

VLM-R1的主要特点:

跨域稳健性:即使在复杂且变化莫测的应用环境中,VLM-R1也能够维持高水平的表现。

出色的泛化能力:与传统的监督微调(SFT)不同,VLM-R1在未见过的任务或数据分布之外的情况下,随着时间的推进,其性能依然不断提升,显示出强大的适应性和灵活性。

易用性强:完整的训练和评估流程使得用户只需几步操作即可快速入门并开展实验,这对于希望利用先进AI技术的研究人员和工程师而言极为便利。

高效的资源利用率:动态优化技术允许使用单一GPU训练大规模参数(高达数十亿级别)的模型,降低了硬件成本门槛的同时提升了效率。

VLM-R1的技术实现:

VLM-R1在Qwen2.5-VL的基础上,对比了R1和传统的SFT方法。结果显示,R1模型在稳定性、泛化能力和理解深度等方面均优于传统SFT模型。此外,VLM-R1还通过一个实际案例展示了其在视觉识别、知识推理和文本表达方面的专业能力。

VLM-R1的应用场景:

VLM-R1在多个实际应用中展现了出色的性能。例如,在智能助理、自动驾驶系统及虚拟现实等领域,其强大的处理能力和灵活性使得它在多模态交互中具备广泛应用的潜力。比如在一个具体的演示案例中,给定一张包含多样食材的照片时,VLM-R1准确地识别出了其中蛋白质含量较高的食品——鸡蛋饼,并进一步解释说明原因。此外,它还能精确定位图片中标记的对象位置,充分展现了其卓越的文字生成、逻辑推理以及视觉感知综合能力。

VLM-R1的相关链接:

GitHub仓库:https://github.com/om-ai-lab/VLM-R1

演示:https://huggingface.co/spaces/omlab/VLM-R1-Referral-Expression

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 开源AI应用平台

开源AI应用平台