dots.llm1:小红书Hi Lab发布的首个开源大模型

小红书于2025年6月7日开放其首个大模型dots.llm1,是小红书Hi Lab(人文智能实验室)自主研发的,dots.llm1是一个1420亿参数的专家混合模型(MoE),通过推理时只激活140亿参数,保持高性能的同时,大大降低了训练和推理成本。

模型特色

使用大规模自然训练数据:使用11.2万亿token非合成高质量训练数据,在现阶段的开源大模型中非常少见,这使得它在中文测试中有强大的性能,以91.3的平均分超过了DeepSeek开源的V2、V3和阿里开源的Qwen2.5 32B和72B。

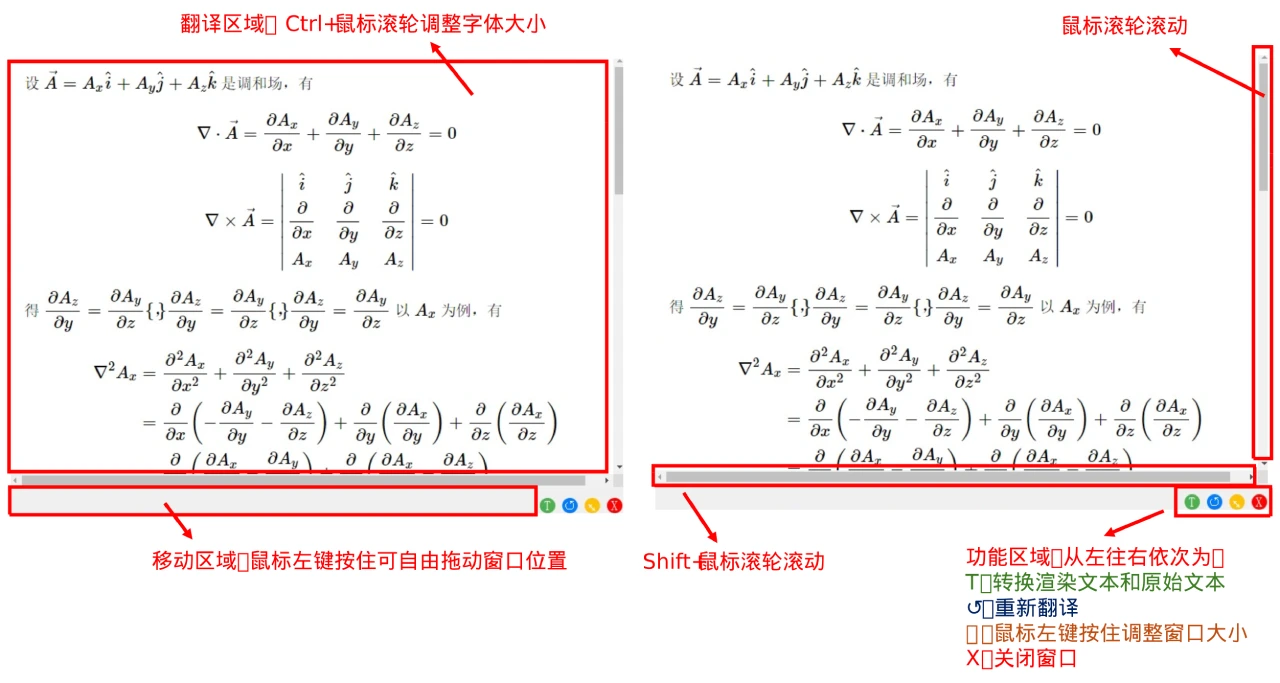

架构设计:使用单向解码器Transformer架构,但将前馈网络替换成MoE。在推理时不激活全部专家网络,而是根据输入标记的性质动态选择激活一小部分专家网络做计算,这种稀疏激活的方式极大降低了算力需求的同时保证了模型高性能。dots.llm1的MoE由128个路由专家和2个共享专家组成,每个专家网络是一个两层的前馈网络,使用SwiGLU激活函数。在每个输入标记的处理上会通过一个路由机制选择6个最相关的专家网络,加上2个共享专家,总共激活8个专家网络。

注意力层优化:使用经典的多头注意力机制(MHA),且在其基础上添加了RMSNorm归一化操作,避免了输入值过大或过小对模型训练的影响,从而提高了模型的稳定性和性能。

负载平衡策略:在MoE模块上引入了无辅助损失负载平衡策略。

模型性能

中文测试:中文测试表现出色,如在CLUEWSC语义理解上得分92.6,为业内领先水平;C-Eval综合知识测试得分92.2超过了包括DeepSeek-V3在内所有对比模型;中文任务平均得分80.5,明显领先;以91.3的平均分超过了DeepSeek开源的V2、V3与阿里 open Qwen2.5 32B、72B。

数学推理:在MATH500基线测试得到84.8分,接近行业顶尖;在aiME24竞赛题上得分33.1,体现出处理复杂数学问题的能力;CNMO24(中国数学奥林匹克)得分40.6,数学综合得分60.9。

英语和代码能力:在MMLU、DROP、 GPQA等英语基准测试与Qwen相当,平均得分64.4;代码能力平均分达到了Qwen2.5的水平。

指令和人类偏好对齐:在IFEval、AlpacaEval2、ArenaHard等指令和人类偏好对齐上,平均得分为77.9,表明模型能够准确理解和执行复杂的指令。

成本控制优势

与Qwen2.5-72B相比,dots.llm1在训练每万亿token时,GPU小时从340K减少到130K,效率提升得益于其独特的通信和计算重叠方案及高效的分组GEMM实现。

模型支持与应用场景

支持功能:支持中英双语,上下文长度达32768个token,还支持function call功能,官方提供的mmlu-pro评测分数比Qwen3-235b-a22b好,但与最新的DeepSeek-V3相当。

应用场景:结合小红书生活方式分享平台积累的海量高质量UGC内容,以及日均近6亿的搜索量与70%月活用户使用搜索功能,dots.llm1在生活场景对话、创意写作、生活经验答疑等方面有其独特的应用优势,小红书也正在围绕这一点构建自己的AI技术体系。

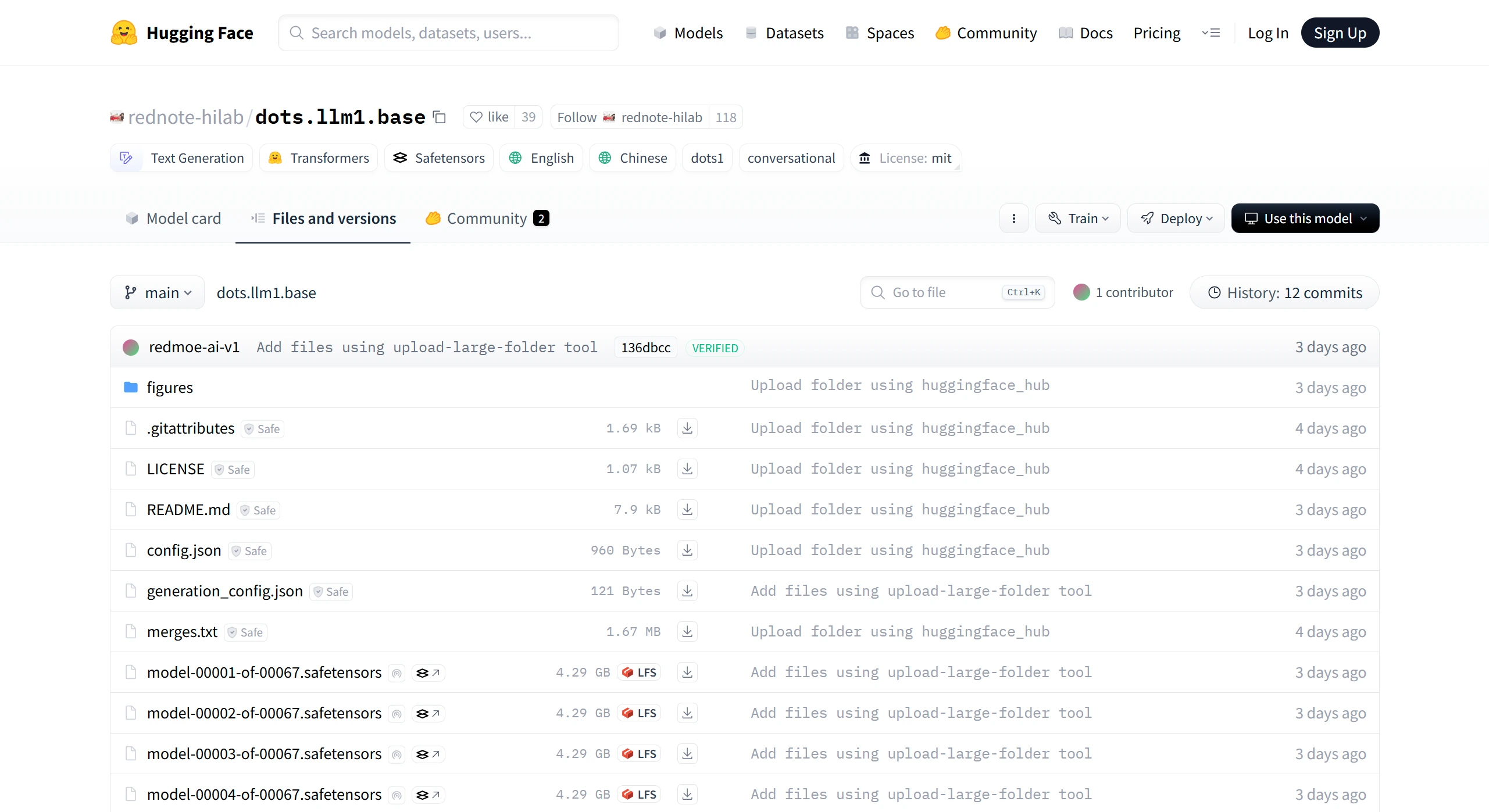

开源地址:https://huggingface.co/rednote-hilab/dots.llm1.base/tree/main

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 开源AI应用平台

开源AI应用平台