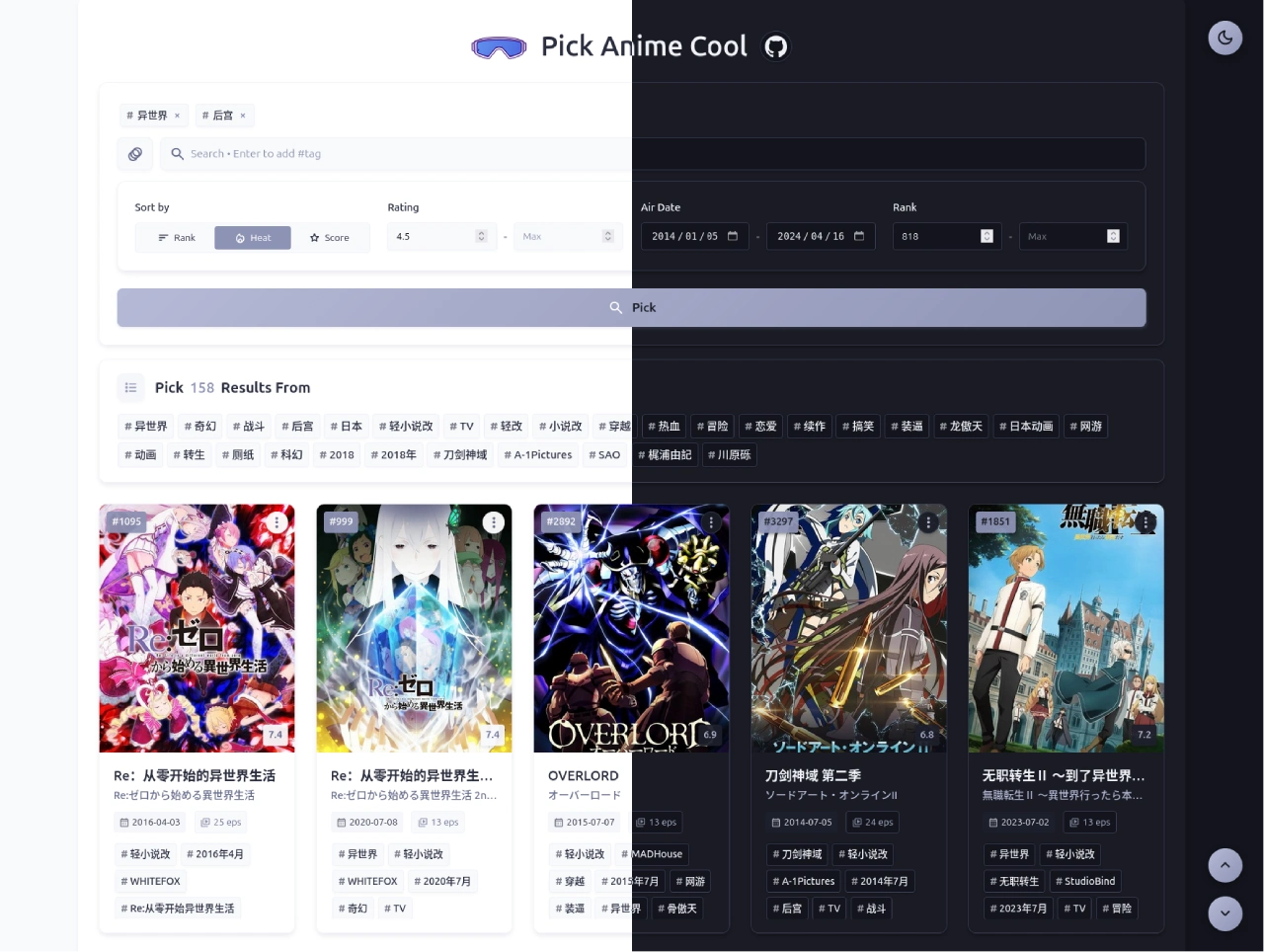

SceneSplat:斯坦福大学和谷歌联合开发的开源3D场景理解工具

SceneSplat 是斯坦福大学和谷歌联合开发的开源 3D 场景理解工具,主要让 3D 高斯模型听懂人类语言指令,实现从文字到 3D 场景的转换。

SceneSplat技术原理

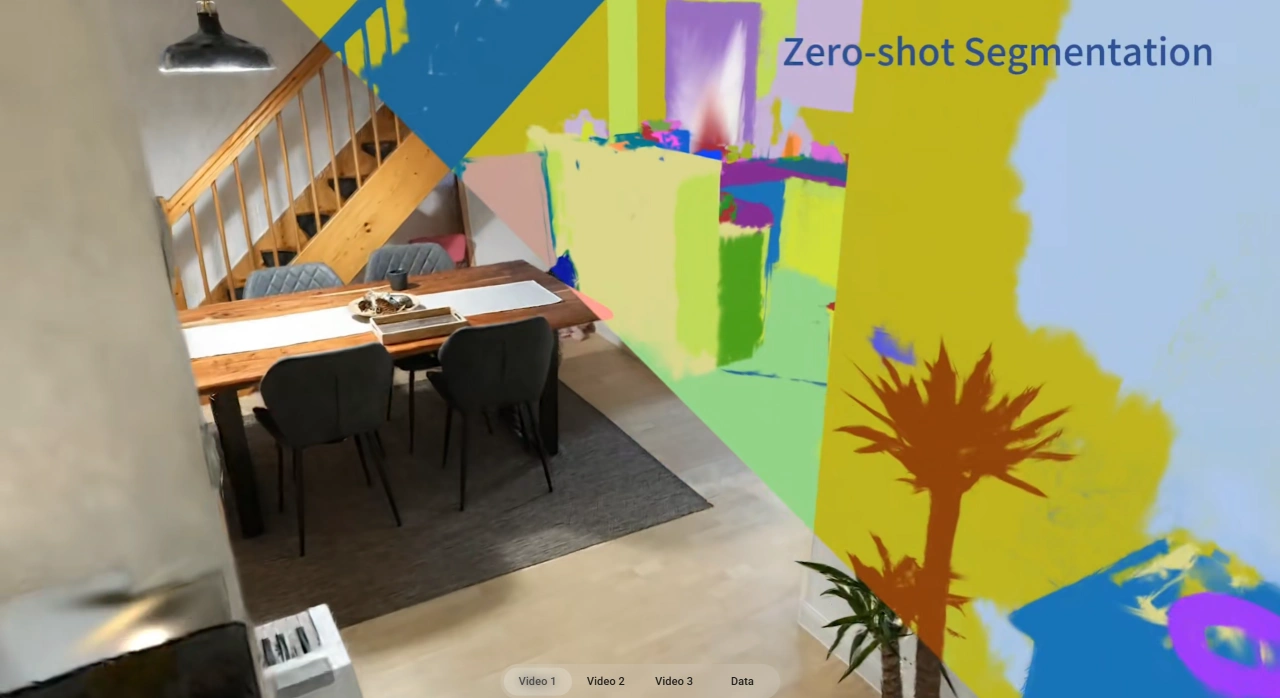

端到端视觉语言预训练架构:通过同时学习语言描述和对应的 3D 场景,让模型听懂自然语言指令并转化成 3D 场景。比如输入“把书架放在靠窗的墙边”,模型能自动识别关键信息并准确放到三维空间里。

跨模态特征对齐:把 3D 高斯表示和视觉语言模型结合,通过多尺度特征提取和跨模态注意力机制,提升对复杂语言指令的理解能力。

自监督学习方案:能从未标记的场景里学到更多 3D 特征。

SceneSplat数据集

SceneSplat - 7K:首个室内场景大规模 3DGS 数据集,有 7916 个场景,来自 ScanNet 和 Matterport3D 等七个现有数据集。生成这个数据集大约需要在 L4 GPU 上运行 150 天。

SceneSplat - 49K:包含多种来源的室内外场景,是目前最全的开源数据集,有复杂且高质量的完整场景级别 3DGS 重建内容,能推动可泛化 3DGS 场景理解发展。

SceneSplat优势与特点

集成语义理解:首次在 3D 高斯模型里实现语义理解应用,突破了传统 3D 图形系统处理语义的局限。

原生运行在 3DGS 上:是首个能在 3DGS 上直接运行的大规模 3D 室内场景理解方法,避免了传统方法数据转换时的信息损失和计算延迟。

高效泛化能力:在开放词汇和语义分割测试中达到了当前最优效果。

SceneSplat应用场景

AR/VR:能实时处理 3D 点云,用自然语言回答问题并精准定位,让 AR/VR 交互更自然。

自动驾驶:帮自动驾驶系统更好理解复杂 3D 环境,提高决策准确性和安全性。

智能机器人:让机器人听懂人类指令,更精准完成任务。

3D 游戏开发:通过自然语言指令快速生成复杂 3D 环境,提升开发效率和游戏世界的动态生成能力。

相关资源

论文链接:https://arxiv.org/abs/2503.18052

项目主页:https://unique1i.github.io/SceneSplat_webpage/

数据集:https://huggingface.co/datasets/GaussianWorld/scene_splat_7k

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 开源AI应用平台

开源AI应用平台