RLAMA:开源的本地文档问答工具,可高效管理和检索文档

RLAMA是什么?

RLAMA是一个由 DonTizi 开发的开源工具,用于创建、管理和与基于文档的检索增强生成(Retrieval-Augmented Generation, RAG)系统进行交互。RLAMA通过连接到本地的Ollama模型,为用户提供强大的文档问答功能。

RLAMA主要功能

创建RAG系统:通过指定文件夹路径,RLAMA可以对文件夹中的文档进行索引,并创建一个RAG系统。

交互式问答:用户可以通过命令行与RAG系统进行交互,提出问题并获取基于文档内容的答案。

管理RAG系统:用户可以列出所有已创建的RAG系统,或者删除不再需要的系统。

更新与版本管理:RLAMA支持通过命令行更新到最新版本,并显示当前版本信息。

RLAMA技术栈

核心语言:Go,因其高性能、跨平台兼容性和单二进制分发特性。

命令行框架:Cobra,用于构建命令行界面。

LLM集成:通过Ollama API实现嵌入和补全功能。

存储:基于本地文件系统(JSON文件)的存储,简单且便于移植。

向量搜索:自定义实现余弦相似度算法,用于嵌入检索。

RLAMA的应用场景

技术团队的文档管理:帮助团队成员快速找到所需的代码示例或解决方案。

研究人员的知识检索:快速定位关键内容。

个人知识管理:作为强大的知识库工具,帮助个人用户快速找到所需内容。

RLAMA安装使用

1、安装:通过终端运行以下命令即可:

curl -fsSL https://raw.githubusercontent.com/dontizi/rlama/main/install.sh | sh

2、使用:用户可以通过简单的命令行指令创建、管理和使用RAG系统。

RLAMA优势

数据安全:所有数据都在本地处理,不用担心隐私泄露。

高效问答:通过强大的语言模型,快速理解问题并提供相关答案。

简单易用:安装和使用简单,适合新手。

开源项目:可以根据需求进行定制,参与社区开发。

RLAMA支持的文档格式

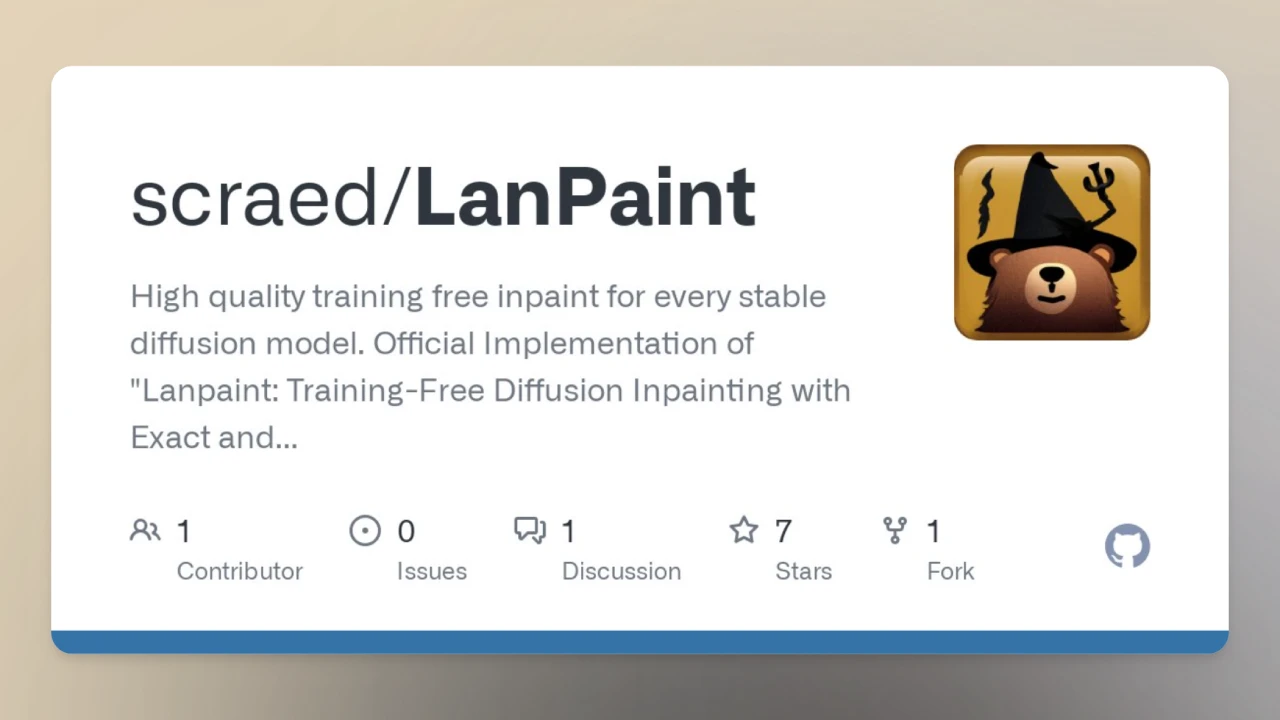

GitHub仓库地址:https://github.com/dontizi/rlama

RLAMA官网:https://rlama.dev/

相关文章

MaxKB:基于LLM大语言模型的知识库问答系统

2024-06-17

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 开源AI应用平台

开源AI应用平台