RelightVid:根据用户输入的文本描述对视频进行光照调整

RelightVid是什么?

RelightVid是一种视频重照明技术,视频版的IC Light,它可以根据用户输入的文本描述、背景视频或HDR环境贴图等条件,对视频进行光照调整,让视频在不同光照条件下呈现出逼真的效果。它通过特殊的模型架构和训练方法,实现了对视频的高质量重照明,同时保证了视频帧之间的连贯性,避免出现闪烁或跳变的情况。

RelightVid功能

文本条件重照明:用户输入文本描述,如“阳光透过树叶,形成斑驳光影”,RelightVid 就能模拟出相应光照条件下的视频效果。

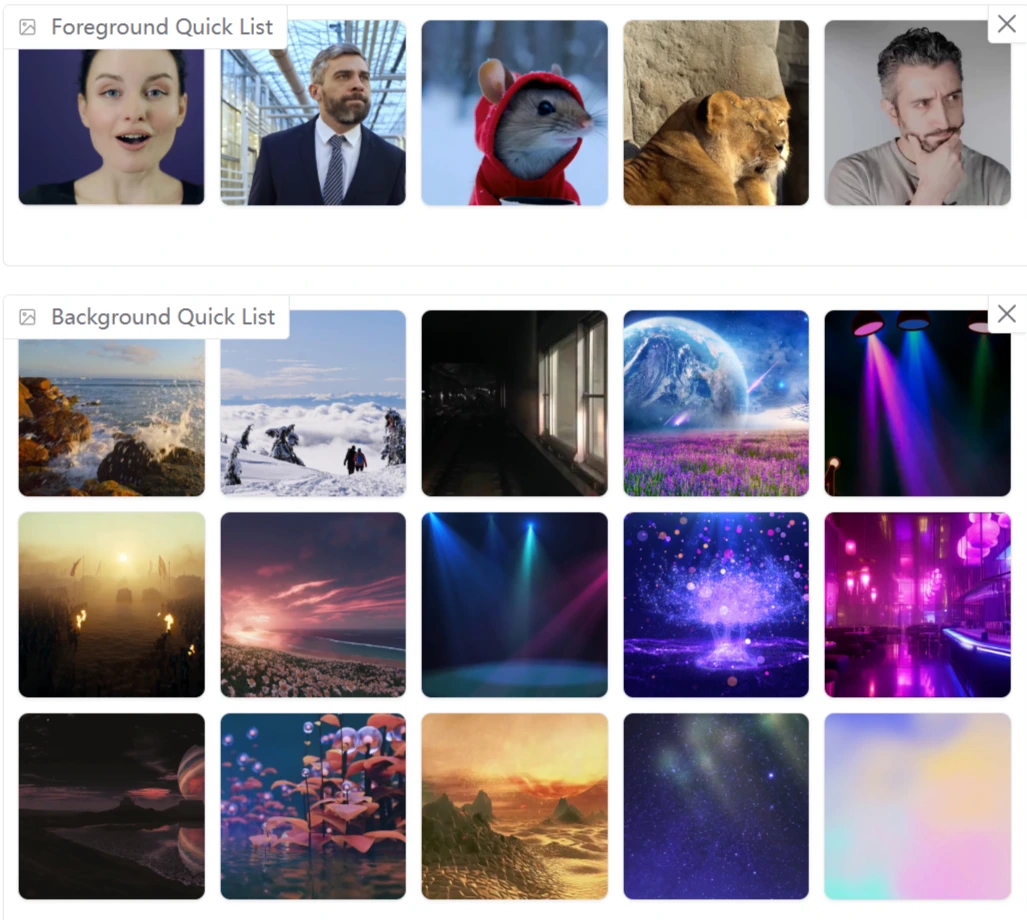

背景视频条件重照明:以背景视频作为光照条件,动态调整前景对象的光照,使前景与背景光照协调一致。

HDR 环境贴图条件重照明:利用 HDR 环境贴图精确控制光照,实现高质量的重照明效果。

全场景重照明:同时对前景和背景进行重照明,使整个场景与光照条件相匹配。

前景保留重照明:改变前景对象的光照,而保留背景不变,适用于突出前景对象的场景。

RelightVid技术原理

扩散模型扩展:基于预训练的图像重照明扩散模型(如 IC-Light),扩展架构支持视频输入,引入时序层捕捉帧间时间依赖性,确保重照明的时序一致性。

多模态条件联合训练:可同时使用背景视频、文本提示和 HDR 环境贴图作为条件,通过编码器将条件嵌入模型中,基于交叉注意力机制实现协同编辑。

光照不变集成(Illumination-Invariant Ensemble, IIE):通过亮度增强输入视频并平均预测噪声,提高模型在不同光照条件下的鲁棒性,防止反照率变化。

数据增强管道(LightAtlas):基于真实视频和 3D 渲染数据生成高质量的重照明数据对,为模型提供丰富的光照先验知识,增强对复杂光照场景的适应能力。

优势与局限

优势:

时序一致性:通过引入时序层,有效保证了视频重照明的时序一致性,避免了闪烁或跳变等问题。

多模态条件控制:支持多种模态的条件控制,用户可根据需求灵活调整光照效果。

高质量的重照明效果:通过多种技术生成高质量的重照明效果,使视频更加逼真。

局限:

计算资源需求:基于深度学习模型,需要大量计算资源才能运行,限制了其在低端设备上的应用。

对复杂场景的处理能力:在处理非常复杂的场景时,可能会出现不准确或不自然的光照效果。

用户知识要求:用户需要具备一定的视频编辑和光照知识,才能充分利用其功能。

RelightVid使用方式

可以直接访问RelightVid的在线Demo:https://huggingface.co/spaces/aleafy/RelightVid。

在Demo页面上传视频,并根据需要输入文本描述、选择背景视频或HDR环境贴图等条件,即可进行重照明处理。

常见问题

1. RelightVid 与传统视频重打光方法的核心区别是什么?

答:传统方法多基于图像编辑模型直接扩展,缺乏对视频时间连贯性的建模,且难以融合多模态输入(如文本、动态光照)。RelightVid 通过插入可训练时间层和光照交叉注意力机制,显式捕捉帧间光照依赖,并支持文本、背景视频、HDR 地图等多条件输入,实现更自然的动态光照编辑。

2. 数据集构建中如何平衡真实性与多样性?

答:通过双源数据增强实现:

野生视频提供真实光照场景(如厨房窗光、雨夜街灯),确保真实性;

3D 渲染数据通过随机 HDR 地图和相机轨迹生成多样化光照组合(如熔岩火光、软箱柔光),增强模型泛化能力。

两者结合使数据集既包含真实案例,又覆盖传统方法难以获取的极端光照条件。

3. 在技术实现中,如何确保重打光结果的时间一致性?

答:通过动态 HDR 条件输入和时间层双重机制:

动态 HDR 地图作为时间序列输入,约束每帧光照参数(如强度、颜色)的平滑变化;

时间层在扩散模型的 U-Net 中引入帧间特征交互,避免相邻帧出现光照突变。

此外,光照交叉注意力机制进一步跨帧传播光照特征,强化全局一致性。

项目链接

项目官网:https://aleafy.github.io/relightvid/

GitHub 仓库:https://github.com/Aleafy/RelightVid

arXiv 论文:https://arxiv.org/pdf/2501.16330

在线体验 :https://huggingface.co/spaces/aleafy/RelightVid

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 开源AI应用平台

开源AI应用平台