GUIRoboTron-Speech:美团与浙江大推出的首个语音交互GUI智能体

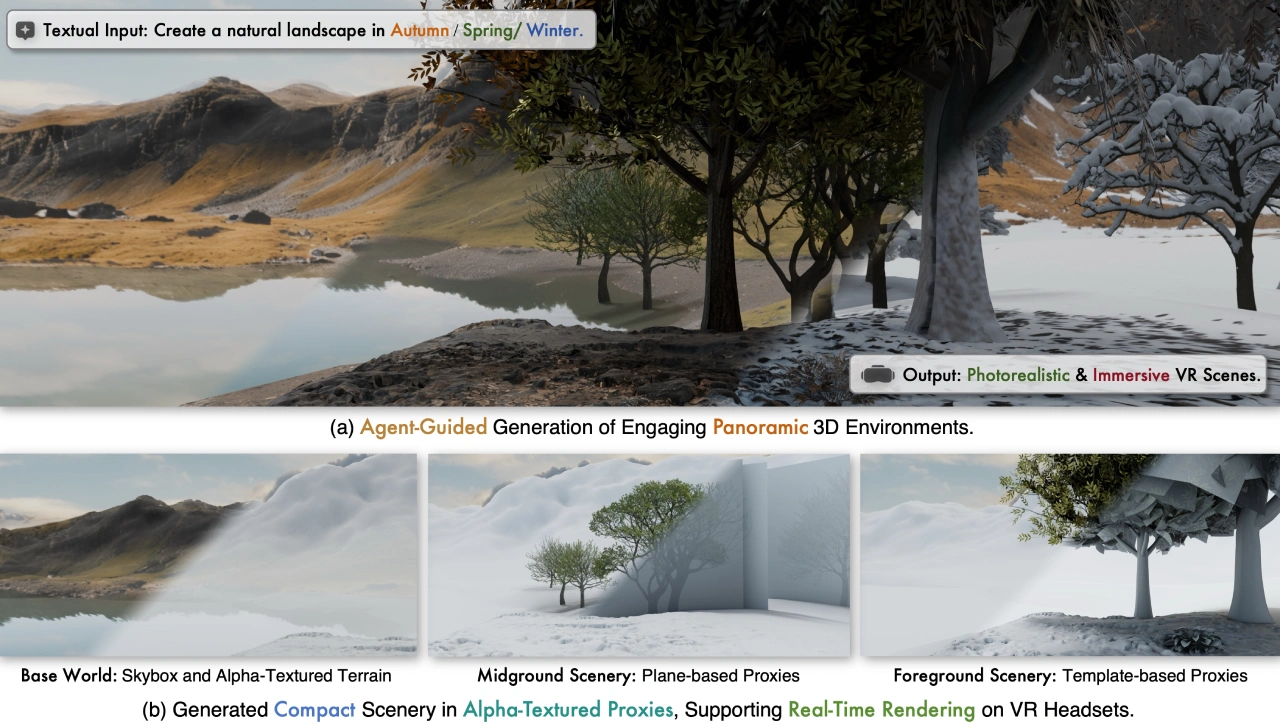

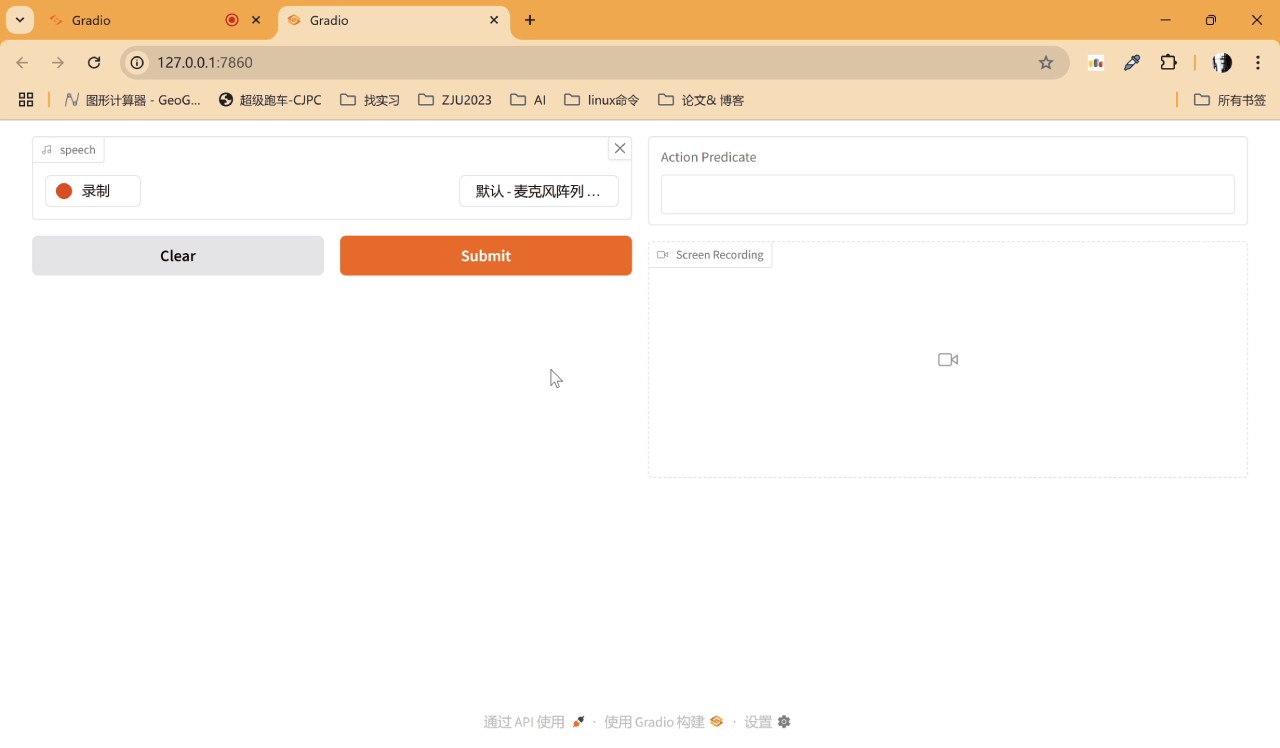

美团和浙江大学合作开发了GUIRoboTron-Speech,这是一个能用语音指令和设备屏幕截图直接做决策的GUI智能体。它能让用户通过语音和设备屏幕截图来操控计算机,避免了传统文本输入的不便。

GUIRoboTron-Speech解决了传统依赖文本的限制。团队通过创建高质量语音数据集、分阶段训练和混合指令训练策略,成功训练了这个智能体,让它在多个任务上表现出色。研究发现,当用户意图明确时,语音指令比文本指令完成任务的成功率更高,未来还会继续提高它处理复杂指令的能力。

核心功能

语音指令驱动:GUIRoboTron-Speech可以直接接收语音指令和设备屏幕截图来预测并执行操作。用户不用手动输入文字,通过语音就能控制GUI代理。

多模态交互:它结合了语音和视觉两种模态,能准确理解语音指令与GUI界面视觉元素的对应关系。

研发方法

数据集生成:由于缺乏语音指令数据集,团队用先进的随机音色文本转语音(TTS)模型,把大规模文本指令数据集转换成多种说话风格和音色的语音指令数据集。

渐进式训练框架:训练分两个阶段:

Grounding阶段:模型学习语音指令与GUI视觉元素的精确对应,比如理解“点击‘确定’按钮”并在截图中找到“确定”按钮。

Planning阶段:模型学习执行多步骤复杂任务,例如“先登录账号,再找最新邮件并打开附件”,展现逻辑推理和任务规划能力。

启发式混合指令训练策略:为解决预训练模型的模态不平衡问题,团队在训练中混合使用语音和文本指令,让模型平等处理两种输入。

性能表现

指令模态对比:在ScreenSpot任务中,仅用语音指令训练的模型平均grounding准确率比仅用文本指令的低1.6%,但采用混合指令策略后,准确率提高了1.9%。

GUI视觉Grounding:在Mobile和Web领域,GUIRoboTron-Speech用语音指令输入时,性能与基于文本指令的先进方法相当。

多步骤任务执行:在AndroidControl和GUIOdyssey等多步骤任务数据集上,它的性能与一些基于文本指令的先进模型相当。

优势与意义

提升交互便利性:用户操作设备时无需手动输入文字,通过语音就能完成各种操作,大大提高了交互的便利性。

拓展应用场景:该技术不仅适用于普通用户的日常便捷操作,还适用于驾驶、医疗等需要双手操作的特殊场景,提供更安全、高效的交互方式。

推动技术发展:GUIRoboTron-Speech为语音交互技术在GUI领域的应用提供了新思路和方法,推动了相关技术的发展。

项目链接

技术论文:https://arxiv.org/abs/2506.11127

Github仓库:https://github.com/GUIRoboTron/GUIRoboTron-Speech

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 开源AI应用平台

开源AI应用平台