MultiTalk:美团开源的音频驱动多人对话视频生成工具

MultiTalk 是美团视觉智能团队开源的音频驱动多人对话视频生成工具。它能根据多人音频、参考图像和文字提示,生成口型同步、肢体自然的数字人对话视频,效果很好。用户只需上传音频、参考图和提示词,就能生成嘴型匹配的对话视频,还能生成歌唱场景和卡通角色。

这个项目有不少实用特点:音频驱动的嘴型同步很精准,能用提示词控制虚拟角色动作,能输出不同分辨率的视频,还能生成长达 15 秒的对话场景。另外,它集成了文本转语音功能,做了多项优化来提高生成效率,支持低显存模式和多 GPU 推理,在单张 RTX 4090 显卡上就能运行。

功能特征

✅音频驱动:输入多人音频,就能生成自然的口型同步和肢体动作

✅单张照片输入:仅用一张参考图像,就能生成多人互动视频

✅复杂动作遵循:支持复杂文字提示,生成符合描述的动作和场景

✅多语言支持:能处理多语言音频,实现精准的唇部同步

✅长视频生成:用自回归方法生成连贯的长视频

✅高效训练策略:通过两阶段训练、部分参数训练和多任务训练,提升模型性能

✅L-RoPE 技术:借助标签旋转位置编码,实现多流音频与人物的精准绑定

✅高质量输出:生成的视频自然流畅,视觉上几乎没有伪影

技术亮点

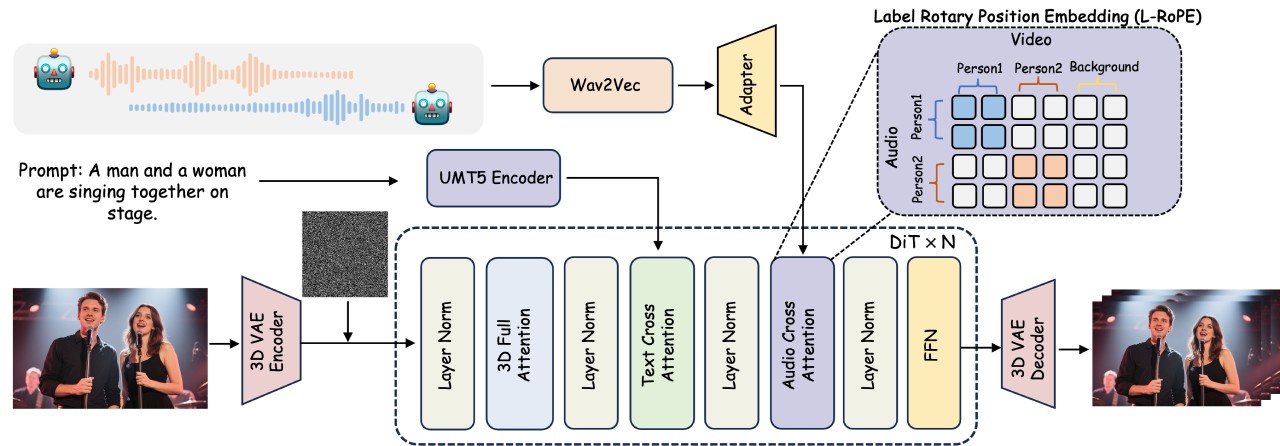

✅首创 L-RoPE 技术:用标签旋转位置编码解决多音频流与人物错位问题,让音频和人物精准对应

✅音频驱动视频生成:输入多人音频、参考图像和文字提示,就能生成口型同步、肢体自然的交互视频

✅局部参数训练 + 多任务学习策略:在保留复杂动作指令跟随能力的同时,实现动态人物的自适应定位

✅多场景支持:可用于影视制作、直播电商等多种场景

技术框架

✅基础模型结构:以 DiT 视频扩散模型为核心,集成 3D 变分自编码器,高效处理视频数据

✅单人音频集成:在每个 DiT 块的文本交叉注意力层后添加音频交叉注意力机制,用 Wav2Vec 提取音频特征,通过音频适配器解决视频和音频时间粒度不匹配的问题

✅多人音频处理:靠 L-RoPE 技术实现多流音频与多个人物的精准绑定,避免 “齐声说话”

训练策略:

✅两阶段训练:先练单人视频生成能力,再练多人物交互和绑定

✅部分参数训练:只更新音频交叉注意力层和音频适配器的网络参数,冻结其他基础模型参数

✅多任务训练:结合音频 + 图像到视频、图像到视频两种训练方式,增强模型的指令遵循能力

性能表现

✅定量评估:在头部和身体动作生成任务中,和多个先进方法相比,在唇形同步(Sync-C、Sync-D)和视频质量(FID、FVD)上表现突出

✅定性评估:处理复杂交互场景时效果好,能生成精准响应复杂文字提示的视频,视觉伪影少,画面自然真实

✅长视频生成:用自回归方法,把之前生成视频的末尾部分作为条件,生成新的视频片段,保证时间上的连贯和扩展

适用场景

影视制作:虚拟角色互动、动画配音、特效合成、短片创作

直播电商:虚拟主播互动、产品展示解说、多语言直播

教育领域:虚拟教师互动、语言学习、历史重现

游戏开发:虚拟角色对话、NPC 互动、多人在线游戏

广告营销:虚拟代言人、产品推广、社交媒体广告

虚拟社交:虚拟社交平台互动、虚拟会议

娱乐创意:音乐视频、虚拟演唱会、创意短片

公共服务:新闻播报、公共服务宣传

企业培训:虚拟培训场景、情景模拟

国际交流:多语言对话、文化交流

项目地址

项目主页:https://meigen-ai.github.io/multi-talk/

开源代码:https://github.com/MeiGen-AI/MultiTalk

论文技术:https://arxiv.org/abs/2505.22647

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 开源AI应用平台

开源AI应用平台