ColQwen-Omni:一款开源的多模态RAG模型

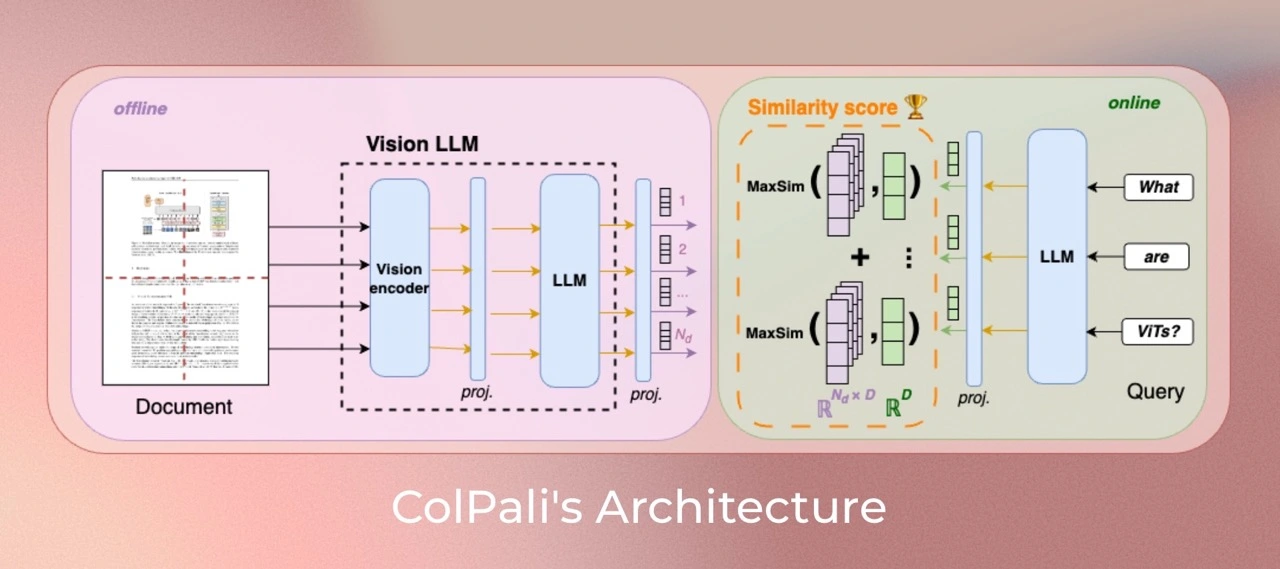

ColQwen-Omni,一款开源的多模态RAG模型,基于 ColQwen2 和 Qwen2-VL 构建,是首个把 ColBERT 检索范式扩展到音频模态的开源模型。

它支持跨模态检索,能处理文本、音频、图像等多种模态数据。训练数据集有 127,460 个查询 - 页面对,63% 是公开学术数据集训练集,37% 是合成数据集,具备零样本音频检索能力。

核心亮点

跨模态检索:支持文本查音频、音频查图像等,所有模态数据在同一向量空间检索。

音视频直处理:不用转录,直接处理音视频原始数据,保留情感、语气和视觉细节。

超快检索:30 分钟音频 10 秒处理完,短视频每段不到 10 秒,单次查询不到 100 毫秒。

TMRoPE 同步:时间对齐多模态嵌入,视频 / 音频帧精准对齐。

轻量高效:30 亿参数,能在 Colab 免费 GPU 上运行。

ColQwen-Omni技术细节

训练策略:用 colpali-engine==0.3.11 训练,基于 Qwen2.5-Omni-3B-Instruct 构建,采用 ColBERT 风格的多向量表示策略。

训练数据:含 127,460 个查询 - 页面对,涵盖公开学术数据集和合成数据集。

动态分辨率处理:支持动态图像分辨率输入,不缩放或裁剪图像,保持原始纵横比。

零样本音频检索能力:训练数据虽只含图像 - 文本对,但模型仍能检索音频内容。

适用场景

音视频检索:文本查 TED 演讲、音频查 YouTube 封面等。

文档问答:PDF / 图像问答,不用 OCR,能解析布局和图表。

教育研究:检索课程视频 / 讲义,进行跨模态分析。

娱乐分析:搜索短视频 / 播客内容,保留情感和环境音。

隐私敏感场景:可在 Colab 本地运行,数据不用上传。

关键问题

ColQwen2.5-Omni 的训练数据集有何特点?

该模型的训练数据集有 127,460 个查询 - 页面对,63% 是公开学术数据集训练集,37% 是合成数据集(含网页爬取的 PDF 页面及 VLM 生成的伪问题)。数据集设计为全英文,方便研究对非英语语言的零样本泛化能力。其中 2% 的样本作为验证集,用于调优超参数。而且,没有多页 PDF 文档同时用于 ViDoRe 和训练集,避免评估污染。语言模型预训练语料和多模态训练中可能含多语言数据。

ColQwen2.5-Omni 在图像处理上与 ColPali 有何不同?

ColQwen2.5-Omni 接收动态图像分辨率,不缩放以改变宽高比,最大分辨率最多创建 1024 个图像补丁;ColPali 会改变图像的宽高比。

如何使用 ColQwen2.5-Omni 进行音频检索?

先安装版本高于 0.3.11 的 colpali-engine(可通过 pip install git+https://github.com/illuin-tech/colpali安装);再导入相关库,加载模型和处理器;处理音频数据集并创建数据加载器,生成音频嵌入向量;最后定义检索函数,输入查询文本,通过模型生成查询嵌入向量并与音频嵌入向量评分,获取_topk 结果,就能展示对应的音频。

项目链接

GitHub地址:https://github.com/illuin-tech/colpali。

模型地址:https://huggingface.co/vidore/colqwen-omni-v0.1。

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 开源AI应用平台

开源AI应用平台