阿里推出QwenLong-L1-32B:一款用于长上下文推理的LLM

2025年5月26日,阿里巴巴团队发布QwenLong-L1-32B,首个基于强化学习训练的长上下文大推理模型,和DocQA-RL-1.6K数据集(含1600个数学、逻辑、多跳推理类文档问答问题)。其框架通过预热监督微调、课程引导强化学习、难度感知回顾采样机制解决长上下文推理强化学习中训练效率低、优化过程不稳定的挑战,在7个长上下文DocQA基准测试中性能优于Openai-o3-mini和Qwen3-235B-A22B,与Claude-3.7-Sonnet-Thinking持平。

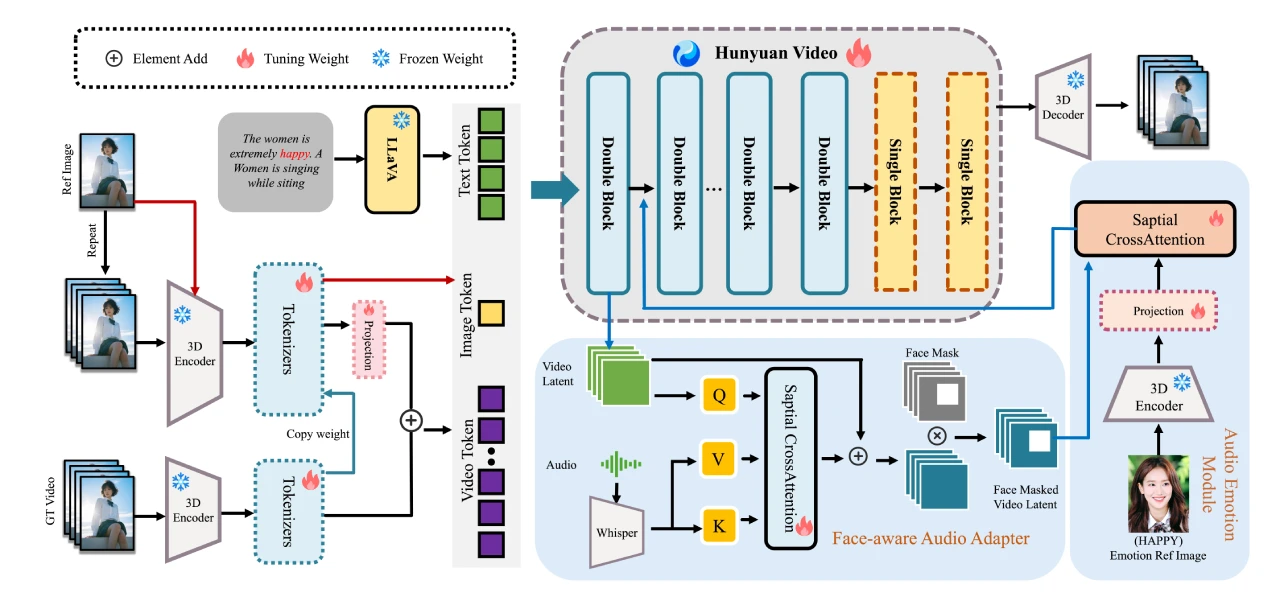

模型框架

核心理念:通过强化学习(RL)将短上下文大规模推理模型(LRMs)适应到长上下文场景中。

主要组成部分:

预热监督微调(SFT)阶段:建立稳健的初始策略。

基于课程的分阶段强化学习技术:稳定策略演化。

难度感知回顾采样策略:激励策略探索。

训练数据

使用了名为DocQA-RL-1.6K的专门强化学习训练数据集,包含1600个涵盖数学、逻辑和多跳推理领域的文档问答问题。

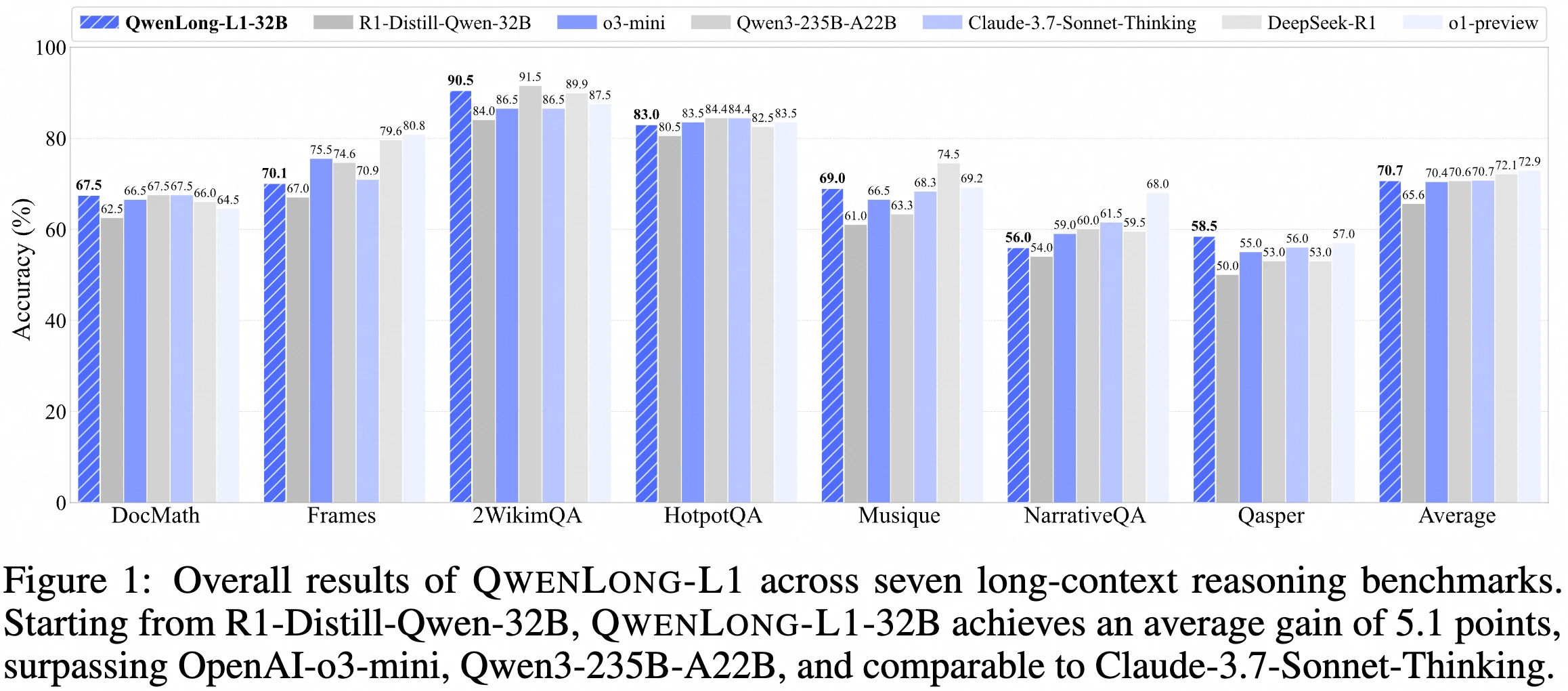

性能表现

在七个长上下文文档问答基准测试中,QwenLong-L1-32B的表现超过了OpenAI-o3-mini和Qwen3-235B-A22B等旗舰级LRMs,达到了与Claude-3.7-Sonnet-Thinking相当的水平,在当前最先进的LRMs中表现出领先性能。

实验设计

构建了一个专门的RL训练数据集DocQA-RL-1.6K,包含1600个文档问答问题,涵盖数学、逻辑和多跳推理领域。

数学推理部分使用了DocMath数据集的600个问题,其中75%用于训练,25%用于评估。

逻辑推理部分通过DeepSeek-R1合成了600个多选题,涵盖法律、金融、保险和生产领域的实际文档。

多跳推理部分从MultiHopRAG和Musique中各采样200个例子,强调跨文档推理。

在七个长上下文DocQA基准测试上进行了评估,包括2WikiMultihopQA、HotpotQA、Musique、NarrativeQA、Qasper、Frames和DocMath。

结果与分析

QwenLong-L1-32B在七个长上下文DocQA基准测试中表现优异,超过了OpenAI-o3-mini和Qwen3-235B-A22B等旗舰LRM模型,性能与Claude-3.7-Sonnet-Thinking相当。

在数学推理基准DocMath上,QwenLong-L1-32B的精确匹配和LLM判断准确率达到了85.3%。

在多跳推理基准HotpotQA上,模型的表现达到了87.6%,显著优于现有模型。

项目链接

Github:https://github.com/Tongyi-Zhiwen/QwenLong-L1

Huggingface:https://huggingface.co/Tongyi-Zhiwen/QwenLong-L1-32B

Modelscope:https://www.modelscope.cn/models/iic/QwenLong-L1-32B

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 AI数字人系统

AI数字人系统