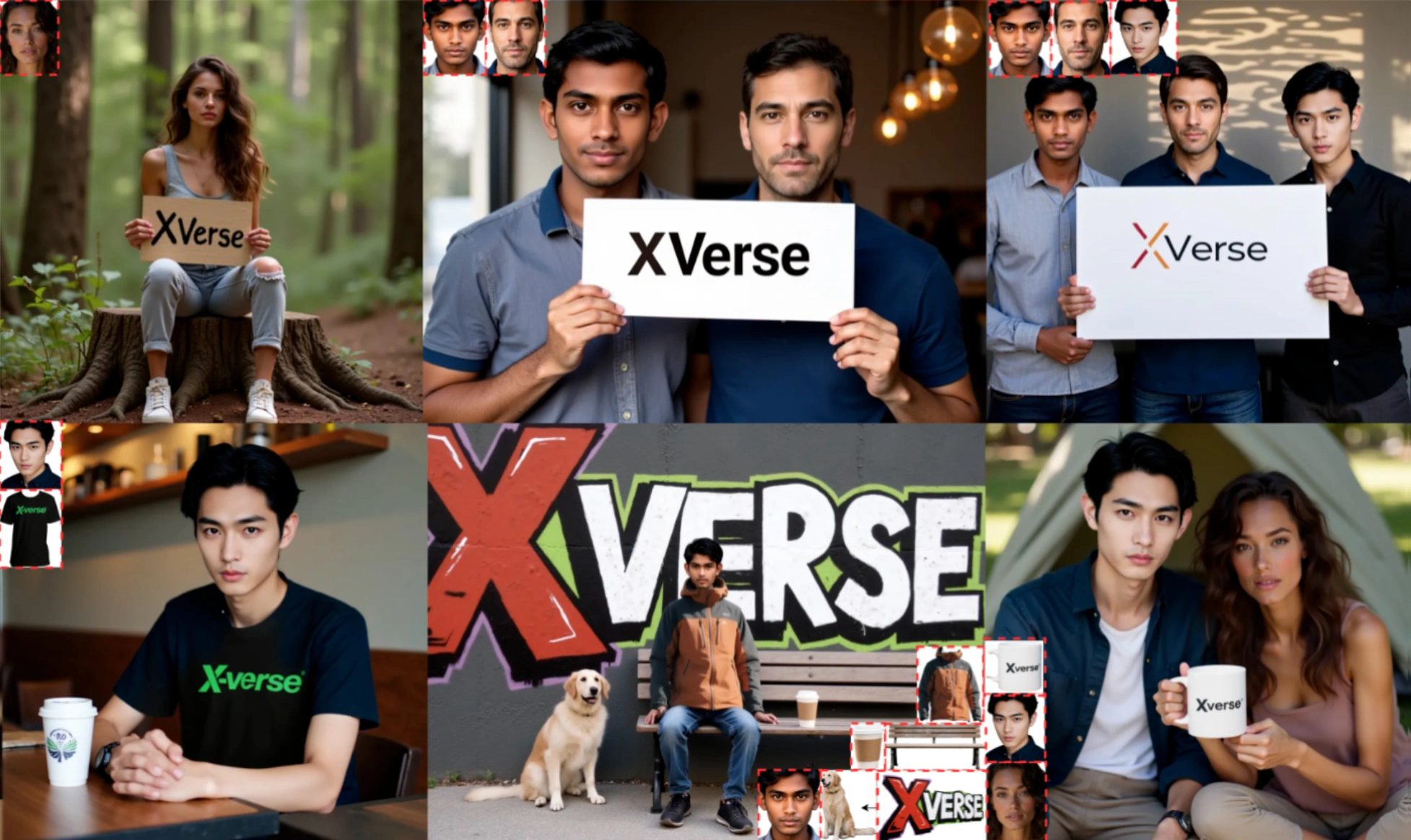

阿里Ovis-U1:具备多模态理解、图像生成、图像编辑三合一能力

2025年6月29日,阿里巴巴国际ai团队推出多模态大模型Ovis-U1,属于Ovis系列最新版本,基于原有架构开发,参数规模为3亿。

该模型整合了多模态理解、图像生成和编辑功能,核心组件包括视觉分词器、视觉嵌入表和大型语言模型。通过优化视觉与文本嵌入的匹配度,解决了传统多模态模型的部分局限,在复杂场景中表现更好。支持文本、图像输入,在数学推理、物体识别等任务中效果突出,既能精准识别图像中的物体或手写文字,也能按指令生成或修改图像。

核心能力

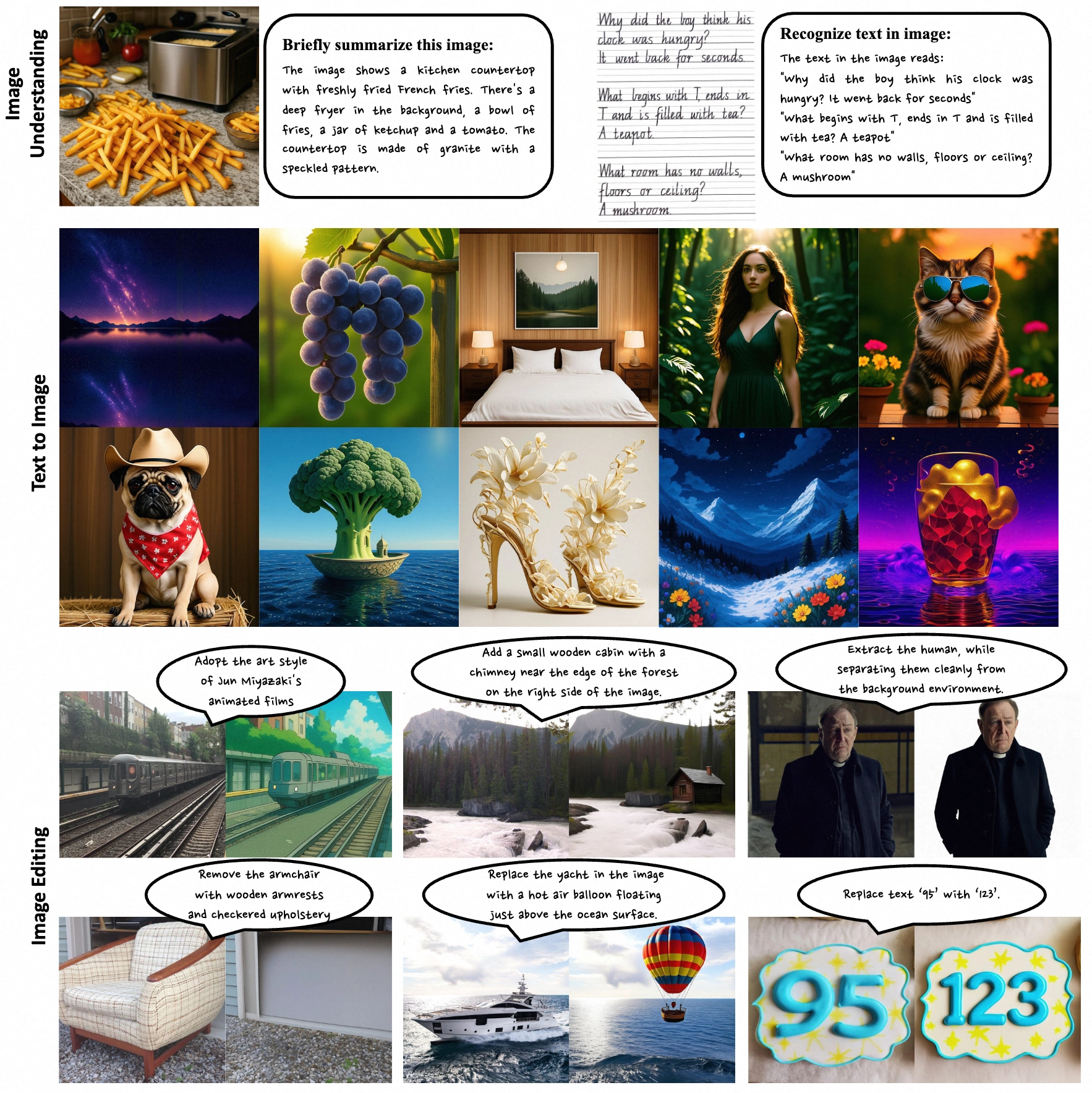

多模态理解:可分析复杂视觉场景与文本内容,回答图像相关问题,完成视觉问答(VQA)、图像描述生成等任务。

文本到图像生成:根据文字描述生成高质量图像,适配多种风格与复杂场景需求。

图像编辑:通过文本指令对图像元素进行添加、调整、替换、删除等操作,支持风格转换。

技术架构

视觉解码器:采用基于扩散的Transformer架构(MMDiT),将文本嵌入转化为高质量图像。

双向令牌细化器:强化文本与视觉嵌入的交互,提升图像合成与编辑效果。

视觉编码器:基于预训练模型(如Aimv2-large-patch14-448)微调,适配多模态任务。

适配器:连接视觉编码器与多模态大语言模型(MLLM),对齐两类嵌入数据。

多模态大语言模型:作为核心模块,处理文本与视觉信息,支持多任务处理。

训练方法

Ovis-U1通过同步训练多模态理解、图像生成和编辑任务,共享知识提升泛化能力。训练分六个阶段逐步优化各任务表现。

数据构成

多模态理解数据:来自COYO、Wukong、Laion等公开数据集及内部开发数据。

图像生成数据:基于Laion5B、JourneyDB数据集及预训练模型生成的详细描述。

图像编辑数据:涵盖参考图像驱动生成、像素级控制等任务的数据。

性能优化

在图像编辑中通过调整文本与图像引导系数(CFG)精准控制指令执行。采用OpenCompass、GenEval等基准测试全面评估模型能力。

应用场景

内容创作:辅助艺术家与视频编辑进行创意构思。

广告营销:根据产品与受众描述生成广告图像与海报。

游戏开发:生成游戏场景、角色及道具图像。

建筑设计:输出建筑概念图及室内布置方案。

科学研究:可视化复杂科学现象与实验场景。

延续Ovis系列开源传统,模型代码、权重及训练数据已通过Apache2.0协议在Hugging Face和GitHub公开,开发者可快速复现部署。

项目地址

GitHub仓库:https://github.com/AIDC-AI/Ovis-U1

HuggingFace模型库:https://huggingface.co/AIDC-AI/Ovis-U1-3B

技术论文:https://github.com/AIDC-AI/Ovis-U1/blob/main/docs/Ovis_U1_Report.pdf

在线体验:https://huggingface.co/spaces/AIDC-AI/Ovis-U1-3B

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 FastbuildAI

FastbuildAI