VRAG-RL:阿里通义团队推出的一款基于视觉感知RAG框架

VRAG-RL是什么?

VRAG-RL是阿里巴巴通义团队最近推出的一款基于视觉感知RAG框架的模型。这款模型在Qwen2.5-VL-3B上性能提升了30%,在Qwen2.5-VL-7B上提升了20%。

VRAG-RL通过强化学习训练,让模型具备多轮思考和推理能力,逐步增强对视觉语言模型(VLM)的理解力和答案准确性。它定义了视觉感知动作空间,使模型能从粗到细聚焦信息密集区域,精准提取关键视觉信息,提升VLM在检索、推理和理解视觉信息方面的能力。

此外,VRAG-RL具备多模态检索和迭代推理能力,通过多轮交互逐步完善对视觉信息的理解,最终生成准确且全面的答案。它适用于多种视觉任务,如图像理解、图表分析、复杂布局解析等场景。

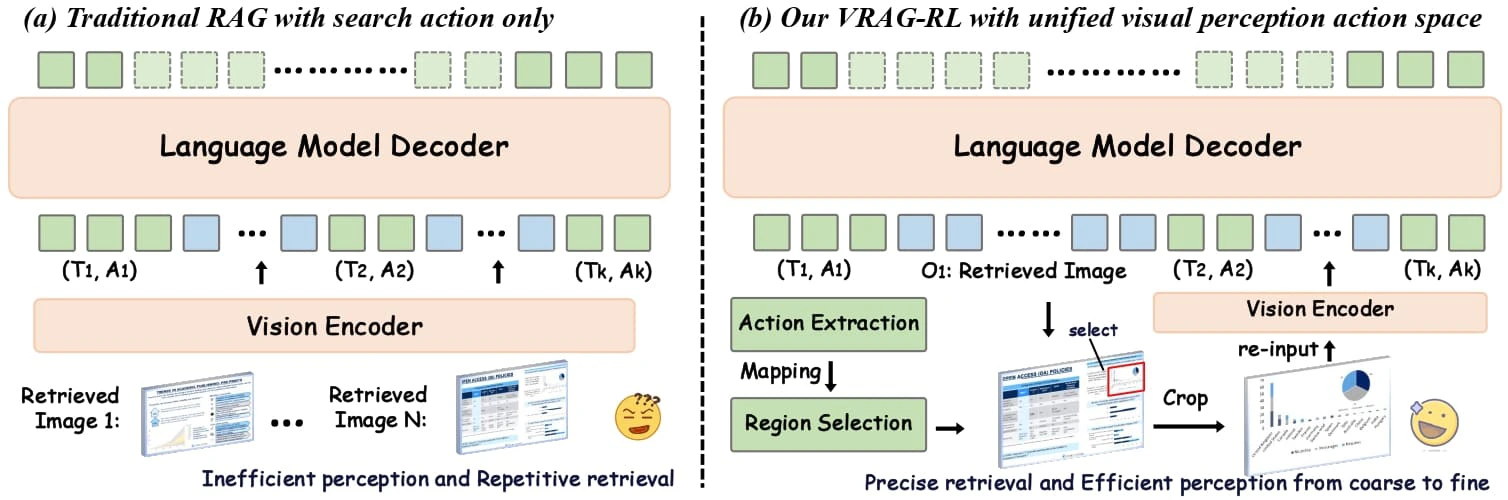

传统RAG方法存在局限性

视觉信息处理能力不足:无法有效解析图像中的信息,缺乏对视觉数据的理解和推理能力。

固定流程限制动态推理:多采用固定的检索 - 生成流程,难以在复杂任务中动态调整推理路径,限制了模型挖掘视觉信息的能力。

检索效率与推理深度不足:在处理复杂视觉任务时,往往无法高效定位关键信息,导致生成结果不够精准。

VRAG-RL的核心创新

视觉感知动作空间:引入多种视觉感知动作,如区域选择、裁剪和缩放等,使模型能从粗粒度到细粒度逐步聚焦信息密集区域,精准提取关键视觉信息。这种从粗到细的感知方式不仅提高了模型对视觉信息的理解能力,还显著提升了检索效率。

强化学习框架:通过强化学习(RL)优化模型的推理和检索能力。模型与搜索引擎进行多轮交互,自主采样单轮或多轮推理轨迹,并基于样本进行持续优化。

综合奖励机制:设计了一种综合奖励函数,包括检索效率奖励、模式一致性奖励和基于模型的结果奖励。这种奖励机制关注最终结果,优化检索过程,让模型更有效地获取相关信息。

多专家采样策略:结合大规模模型的推理能力和专家模型的精确标注能力,使模型能够学习到更有效的视觉感知策略。

多轮交互训练:基于多轮交互训练策略,模型在与外部环境的持续交互中逐步优化推理过程,提升推理的稳定性和一致性。

VRAG-RL的技术优势

提升性能:实验结果表明,VRAG-RL在多个视觉语言基准数据集上均取得了显著优于现有方法的性能表现。任务类型涵盖从单跳到多跳推理、从纯文本理解到图表识别和复杂布局解析等多种视觉丰富场景。

支持多轮交互:能够在推理阶段逐步聚焦于信息密集区域,实现从粗到细的信息获取。

高效训练:引入了业界领先的GRPO算法,通过本地部署搜索引擎模拟真实世界应用场景,实现搜索引擎调用零成本,模型训练更加高效。

VRAG-RL的应用场景

复杂图表分析:从财务报表、科学图表中提取关键数据。

设计稿解析:理解和推理设计稿中的布局与元素。

文档检索:在包含图像、表格的文档知识库中高效检索信息。

多模态问答:结合文本与图像进行多跳推理,回答复杂问题。

项目链接

GitHub仓库:https://github.com/Alibaba-NLP/VRAG

HuggingFace模型库:https://huggingface.co/collections/autumncc/vrag-rl

arXiv技术论文:https://arxiv.org/pdf/2505.22019

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 开源AI应用平台

开源AI应用平台