XVerse:字节跳动推出的多主体图像合成开源工具

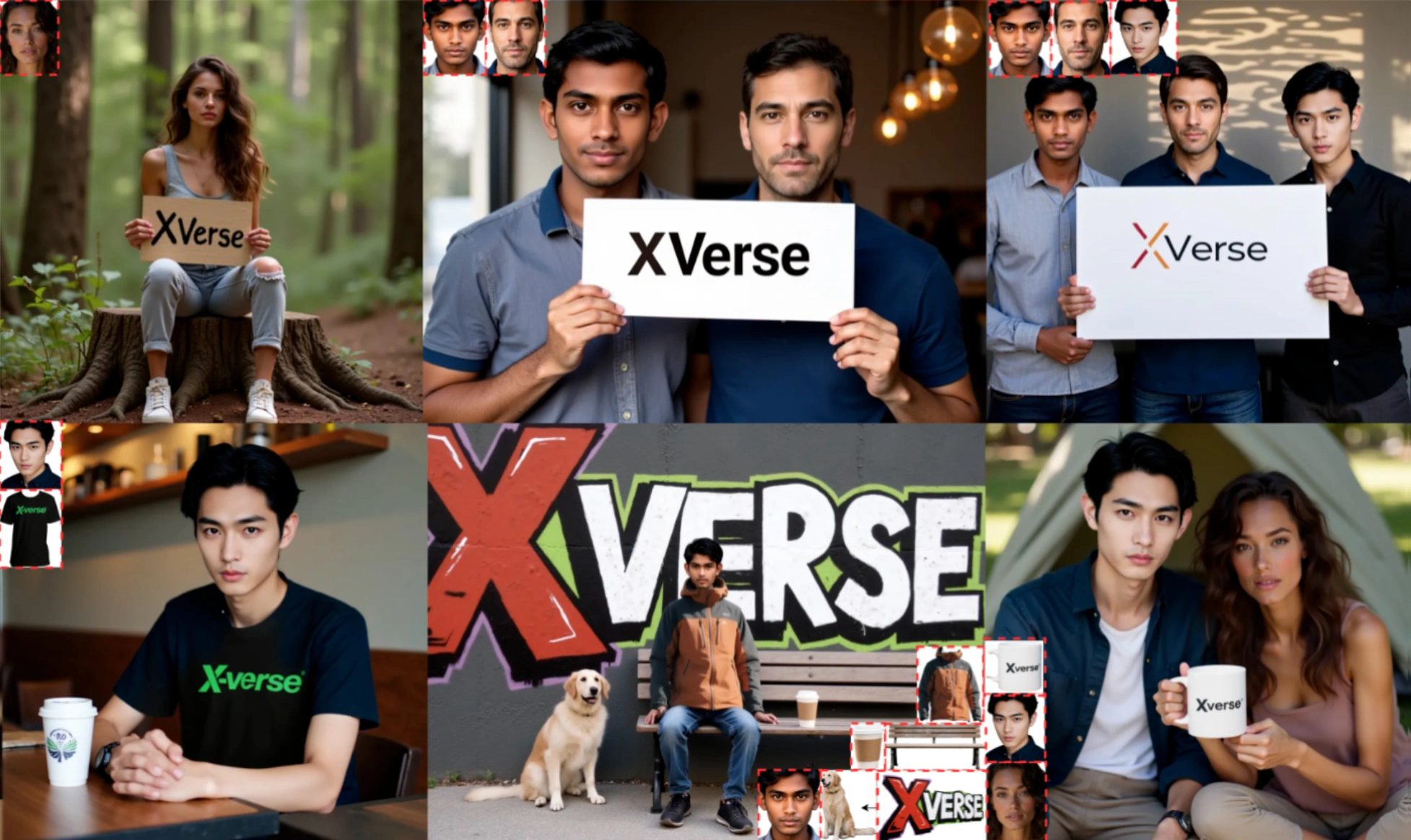

XVerse是字节跳动推出的一款多主体图像合成工具,可以实现高精度的多主体图像生成。它通过用户独立且精确地控制多个主体,大大提高复杂场景的生成能力。

核心功能

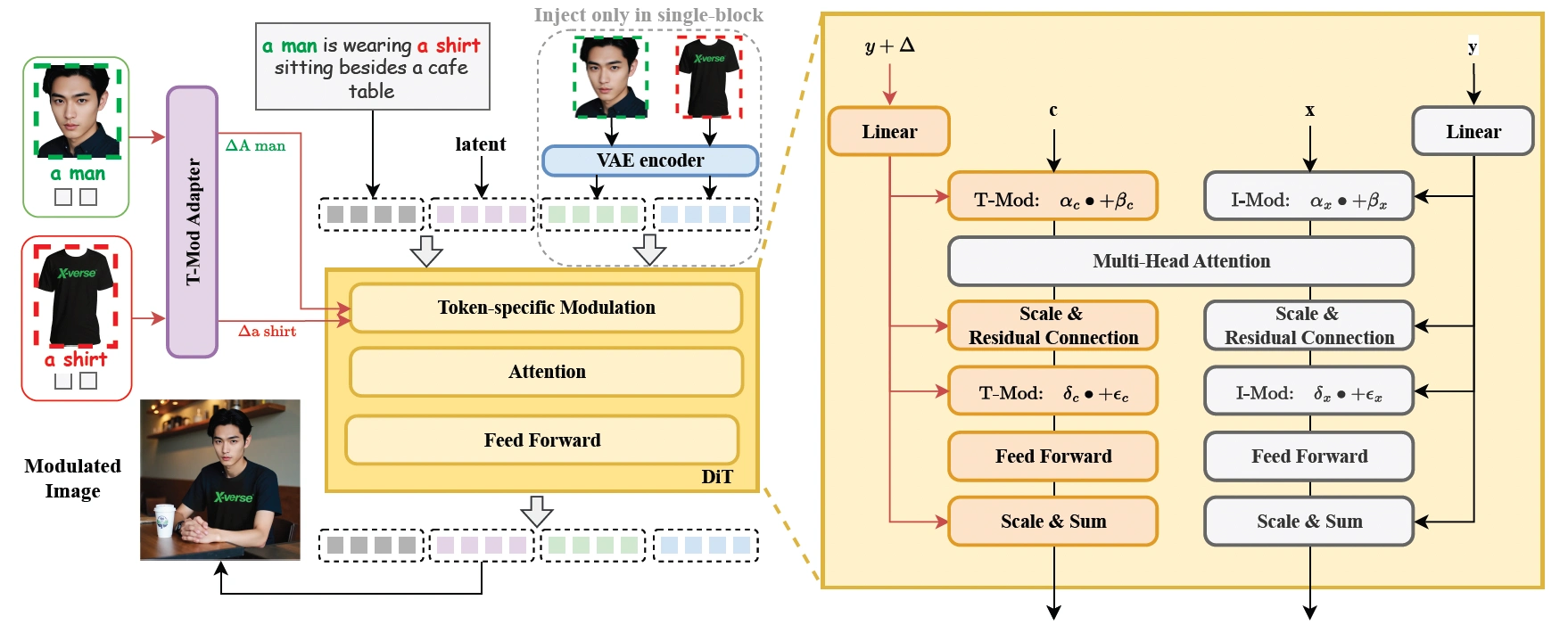

多主体控制:XVerse将参考图像转换为文本流调制的偏移量,精确控制每个主体的身份特征,独立调整语义属性(姿势、风格、光照等)。这解决了传统模型在多主体场景中常见的身份混淆和属性纠缠问题,实现了高保真、可编辑的多主体图像合成。

文本流调制增强:通过结合参考图像特征与文本提示特征生成偏移量,并将其注入特定文本标记嵌入,XVerse实现了对每个主体的精确控制,同时保持了生成图像的整体结构,并能精细调整细节。

VAE编码图像特征:XVerse引入VAE编码的图像特征作为辅助输入,注入到DiTs的单个块中。这有助于捕捉和再现图像细节信息,避免了直接注入图像特征可能导致的伪影和质量下降。

正则化技术:采用区域保持损失,强制模型在未调制区域保持一致性,区分和保持不同主体的特征。通过文本-图像注意力损失,对齐调制模型和参考T2I分支之间的交叉注意力图,确保模型在调制过程中语义交互的一致性和可编辑性。

XVerse技术原理

文本流调制机制:XVerse将参考图像转换为特定于标记的文本流调制偏移量,添加到模型的文本嵌入中,从而实现对特定主体的精确控制,而不干扰图像潜在变量或特征。

VAE编码图像特征模块:为了增强生成图像的细节保留能力,XVerse引入了VAE编码的图像特征模块。该模块作为辅助模块,帮助模型在生成过程中保留更多细节信息,减少伪影和失真。

正则化技术:基于随机保留一侧的调制注入,强制模型在非调制区域保持一致性。正则化主体特定的特征,作为多主体数据集的数据增强策略,提高模型在多主体场景中的区分和保持主体特征的能力。通过计算调制模型和参考T2I分支之间的文本图像交叉注意力图的L2损失,确保调制模型保留与T2I分支一致的注意力模式,保持语义交互的一致性和可编辑性。

应用场景

数字内容创作:XVerse帮助创作者轻松实现对多个主体的精确控制,可用于绘制漫画、创作故事插图、构建复杂虚拟场景等,使作品更生动、丰富、富有想象力。

广告行业:XVerse能够精准控制每个主体的属性,确保广告画面的高保真度和一致性,使广告更引人注目,提升传播效果。

艺术领域:为艺术家提供全新的创作工具,突破传统创作限制,创造独特、富有表现力的艺术作品。

XVerse使用方法

用户需要创建一个包含Python 3.10.16的conda环境,安装依赖项,并下载相关检查点和人脸识别模型。用户界面友好,提供丰富的输入设置选项,包括“检测与分割”功能,可分析上传图像,自动裁剪人脸并生成描述。此外,还提供互动的Gradio演示,用户可以上传图像、输入描述,并实时生成图像,通过调节参数优化效果。

项目地址

项目官网:https://bytedance.github.io/XVerse/

GitHub仓库:https://github.com/bytedance/XVerse

HuggingFace模型库:https://huggingface.co/ByteDance/XVerse

arXiv技术论文:https://arxiv.org/pdf/2506.21416

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 开源AI应用平台

开源AI应用平台