HunyuanVideo-Avatar :腾讯混元推出的语音驱动的数字人模型

HunyuanVideo-Avatar是什么?

HunyuanVideo - Avatar是腾讯混元基于腾讯混元视频大模型(HunyuanVideo)开源的语音数字人模型,通过音频驱动,HunyuanVideo-Avatar 技术能够生成动态人物视频,展现人物的说话、肢体和头部动作及表情,支持多个角色的互动场景。目的在于解决音频驱动人物动画领域的三个难点,生成高动态视频同时保持角色一致性、实现角色与音频的精确情感对齐、支持多角色音频驱动动画。

HunyuanVideo - Avatar功能特点

多景别支持:支持头肩、半身与全身景别,用户可根据需求选择合适的拍摄视角。

多风格与多物种场景:支持多风格(如赛博朋克、2D动漫、中国水墨画等)、多物种(包括机器人、动物等)以及双人场景。

高一致性、高动态性视频生成:能根据输入的人物图像和音频,自动理解图片与音频内容,比如人物所在环境、音频所蕴含的情感等,让图中人物自然地说话或唱歌,生成包含自然表情、唇形同步及全身动作的视频,而且保证视频中主体一致性以及视频的整体动态性。

广泛的应用场景:适用于短视频创作、电商与广告等多种应用场景,可以生成人物在不同场景下的说话、对话、表演等片段,快速制作产品介绍视频或多人互动广告,有效降低制作成本。

多角色精准驱动:在多人互动场景中,能精准驱动多个角色,确保唇形、表情和动作与音频同步,互动自然。

HunyuanVideo - Avatar技术创新

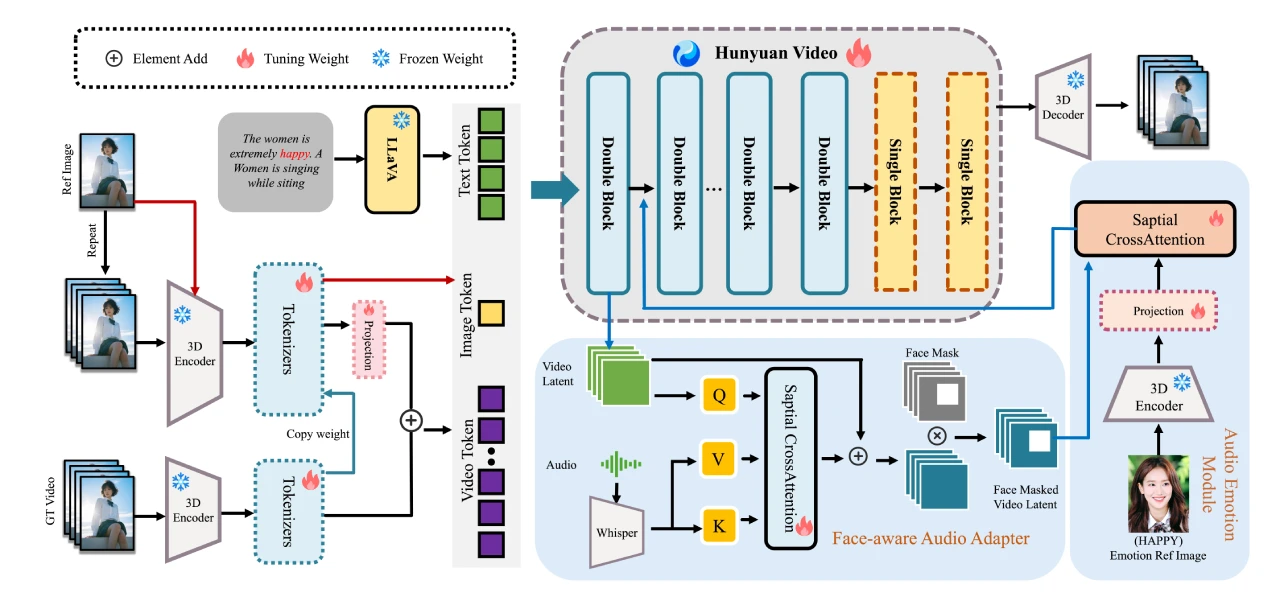

角色图像注入模块:基于多模态扩散Transformer(MM - DiT)架构,确保角色一致性与视频动态性,解决了在生成视频时,既保持人物形象的高度一致性,又能让人物动作流畅自然的问题。

音频情感模块(AEM):会从音频和参考图像提取情感信息,生成细腻的表情和动作,使数字人能根据音频情感展现出相应的面部表情。

面部感知音频适配器(FAA):通过人脸掩码技术隔离角色音频,实现多人场景的精准驱动,可独立驱动不同人物的唇形和表情,避免不同人物之间动作互相影响。

HunyuanVideo - Avatar使用方法

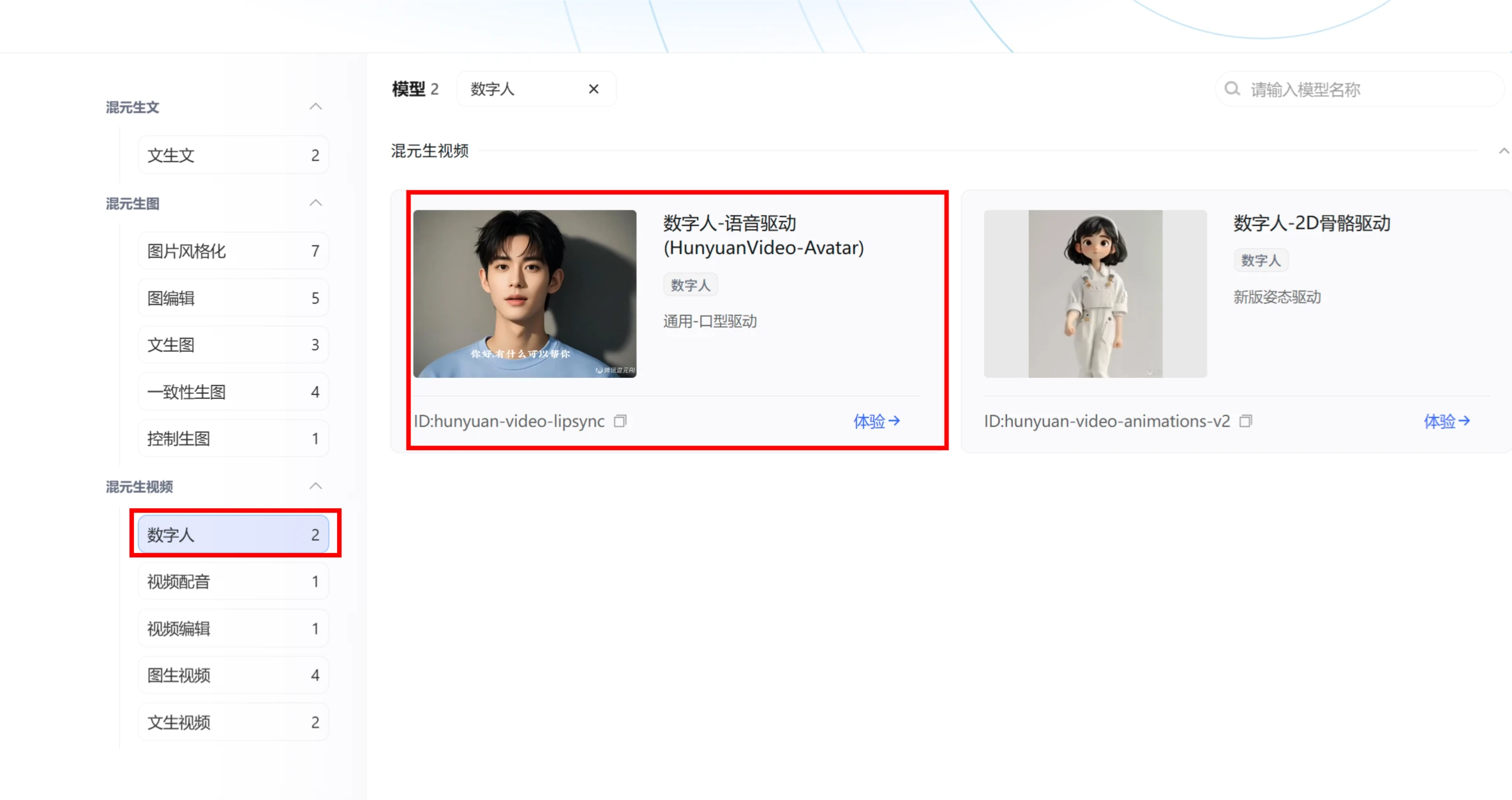

你可在腾讯混元官网(https://hunyuan.tencent.com/)的“模型广场 - 混元生视频 - 数字人 - 语音驱动 - HunyuanVideo - Avatar”中体验,目前支持上传不超过14秒的音频进行视频生成。

HunyuanVideo - Avatar应用场景

短视频创作:可快速生成各种场景下的对话、表演等视频片段。

电商广告:用于制作产品介绍视频、多人互动广告等。

虚拟助手或游戏:创建动画头像,提升交互体验。

项目链接

项目主页:https://hunyuanvideo-avatar.github.io

GitHub地址:https://github.com/Tencent-Hunyuan/HunyuanVideo-Avatar

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 AI数字人系统

AI数字人系统