MOSS-TTSD:开源双语对话语音合成模型

MOSS-TTSD是清华大学语音与语言实验室联合腾讯 ai Lab 等机构开发的开源双语对话语音合成模型。它支持中英文,能把两个说话者的对话脚本转换成自然、有表现力的对话语音。该模型基于 Qwen3-1.7B-base 模型继续训练,用离散化语音序列建模,通过 XY-Tokenizer 把语音压缩到 1kbps,同时保留语义和声学信息。

MOSS-TTSD模型支持中英双语,能零样本克隆多个说话人的音色,最长可生成 960 秒的语音,适合 AI 播客、影视配音、长篇访谈等场景。它的模型权重、推理代码和 API 接口都已开源,还支持免费商业使用。

主要特点

✅高表现力的对话语音:依托统一的语义 - 声学神经音频编解码器、预训练的大型语言模型,以及数百万小时的 TTS 数据和 40 万小时的合成与真实对话语音构建,能生成有自然对话韵律、表现力强的类人对话语音。

✅双扬声器语音克隆:支持零样本双扬声器语音克隆,能根据对话脚本准确切换说话人,生成对话语音。

✅中英双语支持:可生成中英文两种语言的高表现力语音。

✅长语音生成:借助低比特率编解码器和训练框架优化,专门针对长语音生成做了训练。

✅完全开源且可商用:MOSS-TTSD 及其未来更新会完全开源,且支持免费商业使用。

MOSS-TTSD技术原理

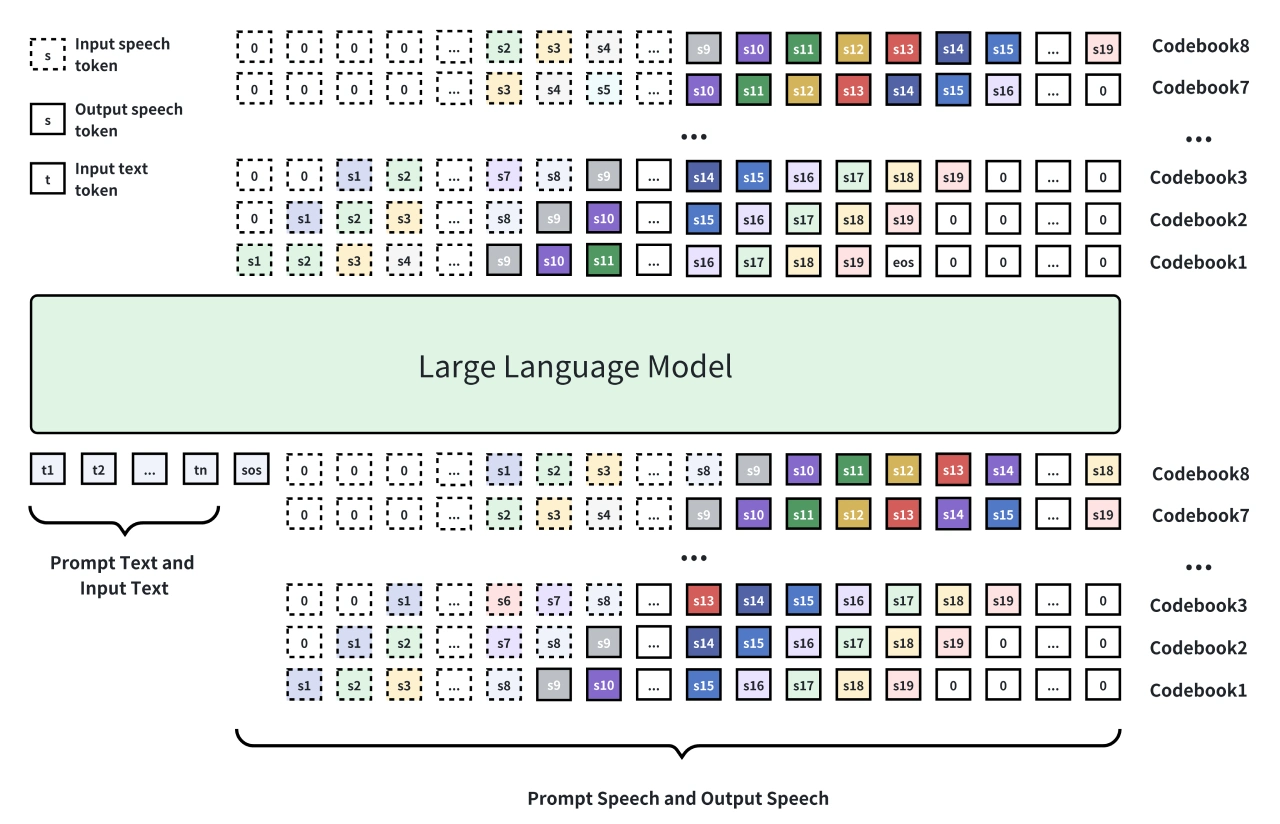

✅模型架构:在 Qwen3-1.7B-base 模型基础上微调,采用离散化语音建模。通过 8 层 RVQ(残差向量量化)把语音信号转换成离散 token 序列,用自回归方式结合 Delay Pattern 生成,最后由解码器还原成语音。

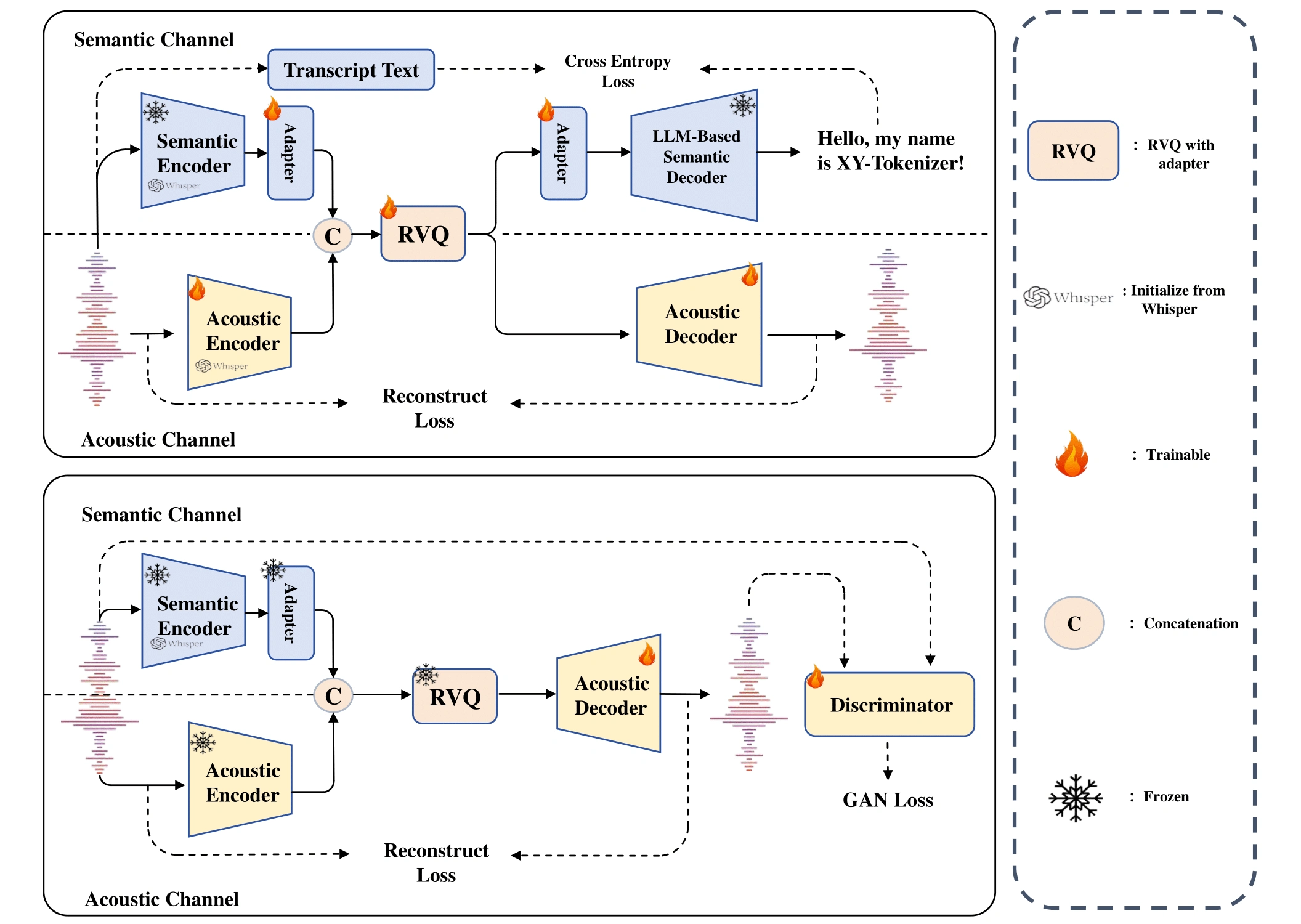

✅核心创新:XY-Tokenizer 有双阶段多任务学习流程。第一阶段同时训练自动语音识别(ASR)和语音重建任务,融合语义和粗粒度声学信息;第二阶段固定编码器和量化器,只训练解码器,加入重建损失和 GAN 损失,增强细节表现。

✅数据规模与预训练:用约 100 万小时的单说话人语音数据和 40 万小时的对话语音数据训练,数据经过严格筛选和标注,还进行了中英文 TTS 预训练。

应用场景

✅AI 播客制作:MOSS-TTSD能自动把文本转成多人对话的播客音频,支持零样本人声克隆和长语音生成,能降低制作成本。

✅影视配音与动画:为影视作品、动画生成自然对话语音,支持多语言切换,提高配音效率。

✅长篇访谈与会议记录:把访谈或会议文本转成语音,保留对话的韵律和情感,方便存档和分享。

优势与特点

✅开源且商用友好:MOSS-TTSD模型权重、推理代码和 API 接口都已开源,用户可以免费商业使用。

✅自然度和表现力:声音自然度和表现力达到业界领先水平。

✅支持声音事件控制:比如笑声等非语言声音,让语音更有表现力。

开源地址:https://github.com/OpenMOSS/MOSS-TTSD

MOSS-TTSD官网:https://www.open-moss.com/cn/

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 开源AI应用平台

开源AI应用平台