ACE-Step:一个新型开源音乐生成基础模型

ACE-Step是什么?

ACE-Step 是一个由 ACE Studio 与 StepFun 联合开发的新型开源音乐生成基础模型,它通过整合基于扩散的生成技术、Sana 的深度压缩自动编码器和轻量级线性变压器,克服了现有音乐生成方法在生成速度、音乐连贯性和可控性方面的局限。该模型在 A100 GPU 上 20 秒内可合成长达 4 分钟的音乐,比基于 LLM 的基线快 15 倍,且在旋律、和声和节奏指标上实现了更好的音乐连贯性和歌词对齐,还支持语音克隆、歌词编辑等高级控制机制,同时也列出了模型存在输出不一致、特定风格表现不佳等局限性。

ACE-Step核心架构

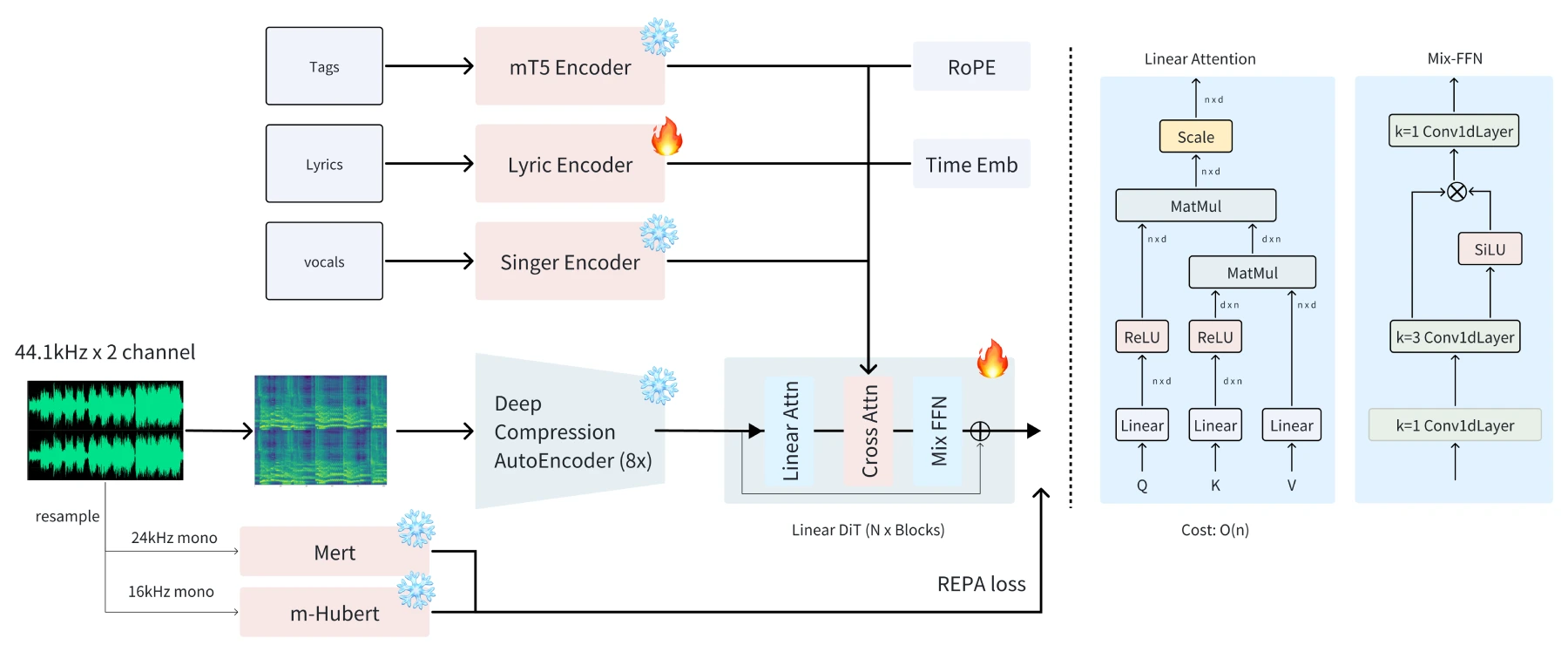

ACE-Step 通过整合扩散模型、深度压缩自编码器和轻量级线性变换器,并利用 MERT 和 m-hubert 在训练期间对齐语义表示(REPA),实现了快速收敛。这种架构设计使其在生成速度、音乐连贯性和可控性之间取得了平衡。

ACE-Step优势

生成速度:ACE-Step 在 NVIDIA A100 GPU 上仅需 20 秒即可生成长达 4 分钟的音乐,比基于大型语言模型(LLM)的基线方法快 15 倍。

音乐连贯性:该模型在旋律、和声和节奏指标上表现出优越的音乐连贯性和歌词对齐能力。

细节保留:ACE-Step 保留了细粒度的声学细节,支持高级控制机制,例如声音克隆、歌词编辑、混音和音轨生成。

ACE-Step功能特点

风格多样:支持主流音乐风格,能处理多种描述格式,如短标签、描述性文本或应用场景描述,在实验性输入测试中也表现良好,还可生成多种乐器的器乐曲目。

多语言支持:支持 19 种语言,但受数据不平衡影响,部分语言表现欠佳,表现较好的前 10 种语言包括英语、中文、俄语等。

可控性强:

Variations Generation:利用无训练的推理时间优化技术,通过调整初始噪声和新增高斯噪声的混合比例,生成与原曲相似度不同的变体。

Repaint:通过对目标音频输入添加噪声并在 ODE 过程中应用掩码约束,可修改特定部分,还能结合变体生成技术实现局部风格、歌词或人声变化。

Edit:运用 flow-edit 技术,能在不改变旋律、人声音色和背景音乐的情况下修改歌词,但一次只能修改小段歌词。

ACE-Step应用场景

Lyric2Vocal(LoRA):基于纯人声数据的 LoRA 微调,可从歌词直接生成人声样本,用于声乐演示、歌曲创作辅助等。

Text2Samples(LoRA):基于纯乐器和样本数据的 LoRA 微调,能根据文本描述生成概念性音乐制作样本,用于创建乐器循环、音效等。

ACE-Step局限性

输出不一致:对随机种子和输入时长敏感,结果不稳定。

风格表现不均:在某些特定风格(如中文说唱)上表现欠佳。

连续性问题:重绘或扩展操作时过渡不自然。

人声质量待提升:合成的人声较粗糙,缺乏细节。

控制粒度不足:需要更精细的音乐参数控制。

多语言歌词优化:需提高对多语言歌词的支持,增强准确性和自然度。

ACE-Step常见问题

ACE-Step 与其他音乐生成模型相比,最大的优势是什么?

答:ACE-Step 最大的优势在于它解决了现有模型在生成速度、音乐连贯性和可控性之间的权衡问题。它能在 A100 GPU 上 20 秒内合成长达 4 分钟的音乐,比基于 LLM 的基线模型快 15 倍,同时在旋律、和声和节奏指标上实现更好的音乐连贯性和歌词对齐,还具备强大的可控功能,如语音克隆、歌词编辑等,这些功能是其他模型难以同时实现的。

ACE-Step 在多语言支持方面存在哪些问题?

答:ACE-Step 虽支持 19 种语言,但受数据不平衡影响,不太常见的语言表现欠佳。在处理多语言歌词时,准确性和自然度有待提高,需要进一步优化对多语言歌词的支持,以提升模型在不同语言下的整体表现。

ACE-Step 的应用场景中,Lyric2Vocal 和 Text2Samples 分别适用于哪些创作环节?

答:Lyric2Vocal 基于纯人声数据的 LoRA 微调,适用于歌曲创作中的声乐演示环节,帮助创作者快速测试歌词演唱效果,还可用于制作引导曲目、辅助歌曲创作和进行声乐编排实验。Text2Samples 基于纯乐器和样本数据的 LoRA 微调,适用于音乐制作前期快速创建乐器循环、音效以及各种音乐元素,为音乐制作提供概念性样本,提高创作效率。

相关链接

https://ace-step.github.io/

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 开源AI应用平台

开源AI应用平台