HunyuanCustom:腾讯混元推出并开源的全新的多模态定制化视频生成工具

HunyuanCustom是什么?

HunyuanCustom 是腾讯混元推出并开源的基于多模态驱动的定制化视频生成框架,可以生成具有特定主题的视频,同时支持文本、图像、音频和视频等多种输入条件。

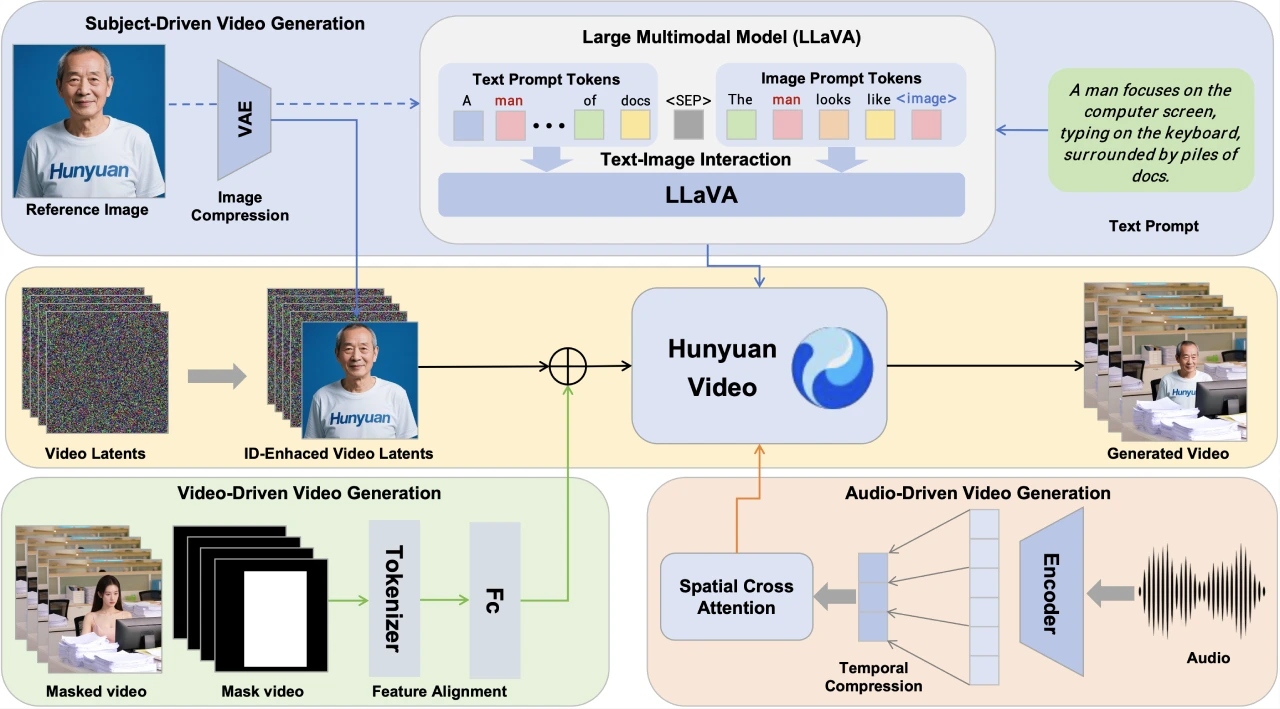

HunyuanCustom模型架构

基于 HunyuanVideo:HunyuanCustom 是在 HunyuanVideo 的基础上构建的,专注于生成与特定主题一致的视频。

多模态融合:引入了基于 LLaVA 的文本-图像融合模块,增强对多模态输入的理解。此外,还设计了针对音频和视频的特定条件注入机制,以实现多模态条件下的视频生成。

HunyuanCustom核心功能

多模态输入生成视频:融合了文本、图像、音频、视频等多模态输入生成视频的能力,具备高度控制力和生成质量。

单主体视频生成:用户只需上传一张包含目标人物或物体的图片,并提供一句文本描述,就能识别出图片中的身份信息,并在完全不同的动作、服饰与场景中生成连贯自然的视频内容。例如上传一张人物照片,输入“他正在遛狗”,即可生成相应视频。

多主体视频生成:用户提供一张人物和一张物体的照片,并输入文字描述,能让这两个主体按要求出现在视频里。比如提供一张人物和一包薯片的照片,输入“一名男子正在游泳池旁边,手里拿着薯片进行展示”,即可生成对应视频。

单主体视频配音:在音频驱动(单主体)模式下,用户可以上传人物图像并配上音频语音,模型便可生成人物在任意场景中说话、唱歌或进行其他音视频同步表演的效果,广泛适用于数字人直播、虚拟客服、教育演示等场景。

视频局部编辑:在视频驱动模式下,支持将图片中的人物或物体自然地替换或插入到任意视频片段中,进行创意植入或场景扩展,轻松实现视频重构与内容增强。

HunyuanCustom技术优势

身份一致性高:通过业内领先的主体一致性建模能力,在单人、非人物体、多主体交互等多种场景,都能保持身份特征在视频全程的一致性与连贯性,人物不会“变脸”,物体不会“漂移”。

可控性强:具有较强的控制信号跟随能力,包括遵循来自文本、参考主体图像和语音等多种模态信号的控制,可较好地生成用户需要对象、场景和动作。

视频生成质量高:得益于腾讯混元视频大模型的强大能力,在人物细节还原、动作流畅性、光影真实度等方面都达到业内领先水平。

HunyuanCustom应用场景

广告场景:可以快捷变换商品背景、模特可以快速换衣服。

电商和客服场景:可以快速低成本制作出生动的数字人商品介绍视频,或者制作特定穿着的数字人客服视频。

影视场景:快速制作短剧和小故事短视频。

教育科普场景:通过音频驱动生成讲解视频。

HunyuanCustom单主体生成能力已经开源并在混元官网上线,用户可以在“模型广场 - 图生视频 - 参考生视频”中体验,其他能力已于5月内陆续对外开源。你可以通过以下链接访问相关信息:

体验入口:https://hunyuan.tencent.com/modelSquare/home/play?modelId=192

项目官网:https://hunyuancustom.github.io/

代码:https://github.com/Tencent/HunyuanCustom

技术报告:https://arxiv.org/pdf/2505.04512

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 开源AI应用平台

开源AI应用平台