Being-M0:具备数据、模型协同特性的人形机器人通用动作生成框架

北京大学和中国人民大学的研究团队在人形机器人动作生成方面取得了重要进展。他们开发了一个名为 Being-M0 的通用动作生成框架,并创建了首个规模达百万级的动作生成数据集 MotionLib。这个数据集通过创新的数据处理流程和详细的标注方法,提取出高质量的动作数据,支持多种数据形式。研究结果表明,利用大量数据和强大模型可以有效提升动作生成效果。团队还提出了 MotionBook 这种新的动作编码方法,进一步优化了动作生成效果。此外,他们通过结合优化和学习的方法,将人体动作高效地应用到多种人形机器人上,为人形机器人的发展提供了有力支持。

数据集 MotionLib

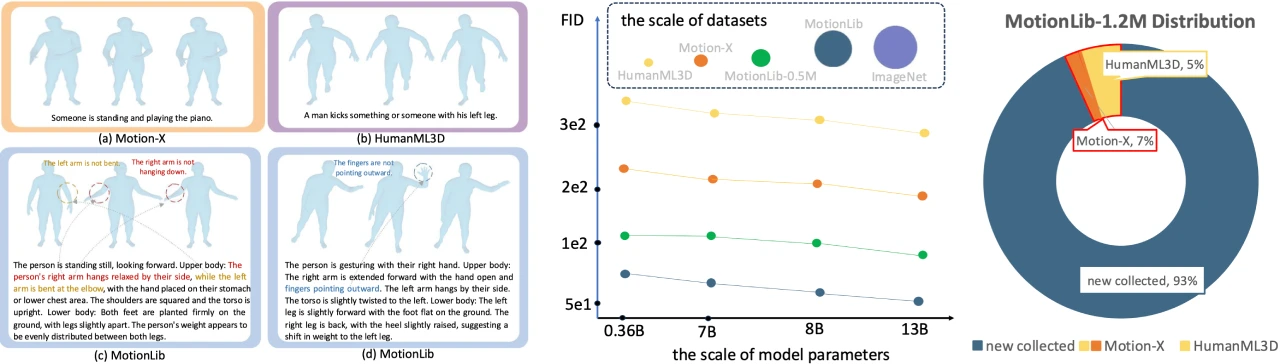

规模与标注:MotionLib 是业界首个百万规模的动作生成数据集,包含超过120万段动作序列,并配有分层且详细的文本标注。该数据集通过系统性地从公开数据集和在线平台收集超过2000万段人体动作视频,并开发了一套创新的数据处理流水线。

数据优化:为提升数据质量,团队使用预训练模型进行2D人体关键点估计,并通过置信度阈值筛选,再利用先进模型生成高精度3D关键点数据。此外,还训练了基于强化学习的策略来优化原始动作,使其更符合物理规律。

动作编码方法 MotionBook

二维无查找量化:提出 MotionBook,将动作序列建模为单通道二维“动作图像”,分别在时间轴和关节轴构建独立编码空间,完整保留运动的多维结构特征。这种方法显著扩展了动作编码器的容量,无需查找对应token,提升了动作表示的效率。

模型 Being-M0

性能与规模效应:基于 MotionLib 和 MotionBook,Being-M0 展现了显著的规模效应,验证了“大数据+大模型”在动作生成领域的技术可行性。在同等数据条件下,模型容量与生成质量呈显著正相关,13B参数的LLaMA-2模型相较700M参数的GPT2,在动作多样性和语义对齐精度等核心指标上均实现突破。

跨平台动作迁移:创新融合优化与学习方法,实现了动作数据向多款人形机器人的高效迁移,显著提升了跨平台运动适配能力。

项目链接

项目地址:https://beingbeyond.github.io/Being-M0/

论文链接:https://arxiv.org/abs/2410.03311

Github:https://github.com/BeingBeyond/Being-M0

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 开源AI应用平台

开源AI应用平台