OmniGen2:开源版的Flux.1 Kontext

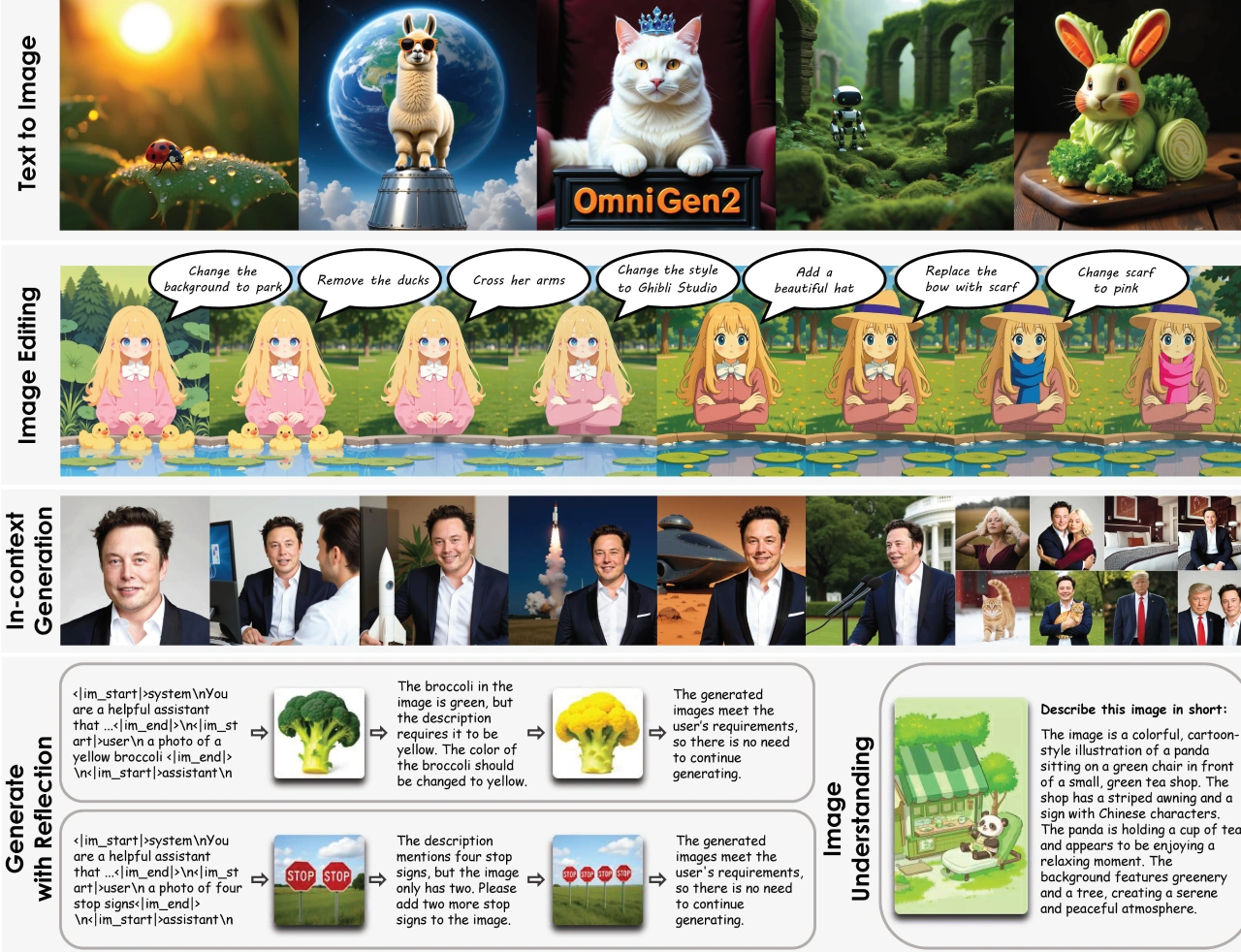

OmniGen2 是智源研究院推出的多模态生成模型。和Flux.1 Kontext类似,能通过文字修改图片,它把视觉理解、文本转图像合成、基于指令的图像编辑,以及主题驱动的上下文生成集成到同一个框架里。这个模型采用解耦架构,在保留语言建模能力的同时,能输出细节细腻且风格统一的视觉效果。另外,它还引入了多模态反思机制,可以对生成结果进行分析、审视并迭代优化,将推理和自我修正融入图像生成过程,让它在生成和理解任务上都有出色表现,成为轻量级开源模型的新标杆。

核心功能

文本转图像生成:用户能根据文本描述生成各种场景和角色的图像,比如 “戴皇冠的猫躺在天鹅绒王座上”“黑暗巫师在古老洞穴里施展魔法” 这类描述。

图像编辑功能:支持对生成的图像进行多种修改,像改变服装颜色、更换背景,或是添加、删除画面元素等操作。

风格转换:可以把图像转换成不同的艺术风格,比如动漫风、油画风都能实现。

角色和场景合成:能把不同图像里的角色或元素组合到新场景中,例如 “让第一张图的女孩和第二张图的男孩在教堂举行婚礼”。

特点

高质量输出:生成的图像细节丰富,视觉效果出众。

灵活的编辑能力:提供多种编辑选项,用户能根据需求定制图像。

开源特性:作为开源项目,为开发者和研究者提供了更多探索开发的可能。

使用场景

创意设计:设计师可以借助 OmniGen2 快速生成设计概念和草图。

内容创作:内容创作者能生成各种场景和角色的图像,用于故事创作、视频制作等场景。

教育与研究:教育工作者和研究人员可以把它作为教学和研究工具,探索多模态生成技术的应用。

应用例子

图像生成:通过文本描述生成各类场景和角色的图像,比如 “戴皇冠的猫躺在天鹅绒王座上”。

图像编辑:对生成的图像进行修改,例如改变服装颜色、更换背景等操作。

图像合成:将不同图像的元素组合到新场景中,比如 “让第一张图的女孩和第二张图的男孩在教堂结婚”。

关键问题

1. OmniGen2 的核心创新点是什么?

OmniGen2 的核心创新在于采用双路径解耦架构整合多模态生成能力,引入多模态反思机制实现输出的自我优化,同时设计 Omni-RoPE 位置嵌入来提升图像编辑和上下文生成的一致性,这些创新让它在轻量级开源模型中树立了新基准。

2. OmniGen2 在图像编辑方面能实现哪些具体操作?

OmniGen2 在图像编辑上能完成多种精细操作,包括对象处理(比如添加或移除对象,像给人物加渔夫帽、去掉画面里的猫)、风格变换(比如把背景改成教室场景、将风格转为吉卜力工作室风格)、颜色调整(比如把裙子颜色改成蓝色)、表情修改(比如让人物露出微笑)、动作编辑(比如让人物举起手)等,同时还能保持未编辑区域的视觉真实感和一致性。

3. 多模态反思机制如何提升 OmniGen2 的生成质量?

多模态反思机制让 OmniGen2 能够评估自己的输出结果,识别出描述与图像内容不符的情况(比如 “三个披萨” 但图像里只有一个时会提示添加)、颜色或位置错误(比如黄色西兰花生成成绿色时会提示改色,狗出现在椅子上而不是黄色餐桌上时会提示调整位置)等问题,并通过迭代优化生成更符合要求的结果,从而增强了输出的可控性、可靠性和质量。

项目主页:https://vectorspacelab.github.io/OmniGen2/

技术论文:https://github.com/VectorSpaceLab/OmniGen2

在线试用:https://huggingface.co/OmniGen2/OmniGen2

注:Flux.1 Kontext是德国黑森林实验室(Black Forest Labs)开发的图像生成与编辑工具。它可以根据文本和图像提示生成和编辑图像,包括修改对象、转换风格、替换背景、保持角色一致性和编辑文本等。和传统文本到图像模型不一样,它支持上下文图像生成,能同时结合文本和图像提示,直接提取和修改视觉概念,生成新的连贯图像。

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 FastbuildAI

FastbuildAI